Im Sommer schien es noch wahrscheinlich, dass die SEOkomm ganz normal stattfinden kann, doch mit fortschreitender Zeit und steigenden Inzidenzen wurde die Situation immer kritischer. Das Team der Online-Expert-Days leistete jedoch großartige Arbeit und ermöglichte die Konferenz unter strengen Hygienemaßnahmen vor Ort. Dabei gab es auch eine Premiere: Zum ersten Mal seit dem Start der SEOkomm vor elf Jahren wurden die Vorträge auch online per Livestream zur Verfügung gestellt. So konnten viele Besucher:innen, denen es nicht möglich war, nach Salzburg zu kommen, trotzdem virtuell teilnehmen. Diese Neuerung änderte die Dynamik der SEOkomm natürlich ein wenig, nichtsdestotrotz war die Stimmung wie immer offen und herzlich.

Das SEO-Team der xpose360 besuchte fast komplett die SEOkomm und zeigt Dir nun, was es aus den interessanten Vorträgen mitnehmen konnte.

Keynote: Action-Replay: Alles auf Anfang?

Bastian Grimm

In der Keynote der SEOkomm 2021 fing Bastian Grimm mit den steilen und radikalen Thesen an, dass Technical-SEO sowie auch Content-Erstellung irrelevant werden und nicht mehr ausschlaggebend für die Rankingbestimmung sein werden.

Zudem stellte er dar, dass „informational Search“ bereits von den SERPs oft ausreichend gut abgebildet werden und Webseiten folglich eher für andere Suchintentionen relevanter werden.

Bastian erwähnte die ungewöhnlich zahlreichen Updates der letzten Zeit und geht darauf basierend davon aus, dass auch zukünftig die Frequenz zunehmen wird. Doch nicht nur das. Auch die Überschneidung der einzelnen Updates wird sich steigern, wie in jüngster Zeit erlebt, was zu einer erhöhten Komplexität führen wird.

Die Frage, die er stellt, lautet: „Warum jetzt und so viel auf einmal?“.

Ohne dem Suchintent zu entsprechen, werden keine langfristigen Rankings mehr haltbar sein – Nutzer:innen müssen finden, was sie suchen. Der Intent wird ein noch größeres Thema werden.

Doch wo geht die Reise hin? Bastian geht davon aus, dass Google ein vollautomatisiertes Recommendet-System wird (persönliche Profile mit Empfehlungen, wie Youtube es macht, als Micro-Recommendet-System).

Mum und Lens waren Top-Themen auf der Search on 21. Darauf basierend stellte Bastian in der Keynote vor, wie Street View es erreicht, z. B. mit Hilfe von Lens die Markenvorkommen je Stadt/Region zu messen. So können Werbeplakate erkannt werden, theoretisch aber auch Kleidung, die Menschen tragen – GDPR mal ausgeklammert.

Zudem ging Bastian näher auf das Thema “maschinell erstellter Content” ein und weist im Zuge dessen darauf hin, dass darin die Zukunft liegen wird. Um solide Ergebnisse zu demonstrieren, stellte er die maschinell erstellten Texte von The Guardian vor. Außerdem sollten Meta-Daten mit GPT-3 erstellt werden, da sowieso keiner „Bock“ drauf hat, sie selbst zu formulieren.

Screaming-Frog für Fortgeschrittene: Tipps & Anwendungsfälle für die Praxis

Stephan Czysch

Der Crawler Screaming-Frog ist eines der wichtigsten Tools für die Arbeit von SEOs. Der besondere Vorteil ist, dass er kontinuierlich in Umfang, Stabilität und Anwendungsorientiertheit erweitert wird, ohne dabei teurer zu werden.

Zu Beginn seines Vortrages zeigte Stephan, wie die wichtigsten Grundeinstellungen im Screaming-Frog getätigt werden müssen. Besonders hilfreich ist es an dieser Stelle, zu wissen, welche Daten der zu crawlenden Seiten für die eigene Analysearbeit benötigt werden.

Hier ging Stephan auf die Möglichkeit ein, dass man mit CSS-Path oder Regex genau definieren kann, wo die Daten auf den einzelnen Seiten stehen. Um diese zu ermitteln, kann man sich in Google-Chrome über die Developer-Tools anzeigen lassen, wie die einzelnen Elemente benannt sind.

Im weiteren Verlauf wurde der Crawl-Vergleich vorgestellt. Dieser ist insbesondere wichtig, um die Desktop-Variante mit der Mobile-Variante einer Seite zu vergleichen. Hier lässt sich zum Beispiel vor allem, wenn man die Rendering-Methode mittels JavaScript gewählt hat, vergleichen, ob in einer der Versionen wichtige Inhalte “vergessen” wurden oder ob sogar Websitebereiche nicht verlinkt wurden.

Auch bei einem Relaunch ist es wichtig, einen Crawl vom alten Zustand der Webseite mit dem Endergebnis zu vergleichen. Und sogar während der Entwicklung kann man die Testumgebung mit dem Live-System abgleichen. Insbesondere beim Crawl der Testumgebung kann man Links, die auf die Live-Umgebung führen, überschreiben und hier auch den URL-Pfad für die Testumgebung angeben. So verhindert man, dass Statuscodes oder Indexierungsanweisungen falsch interpretiert werden und versehentlich bei der Veröffentlichung in gutem Glauben falsch live gehen.

Stephan ging weiterhin darauf ein, dass sich Crawls sehr einfach in Google-Docs übertragen lassen. Somit lassen sich mit Hilfe einer API regelmäßige Reports erstellen, welche schnell beim Auffinden von Veränderungen behilflich sind.

Content-Wildwuchs vs. Informationsarchitektur

Martin Höllinger

Über die Zeit häufen sich bei vielen Projekten die Content-Themen immer mehr an. Schnell verliert man dabei die Übersicht. Martin Höllinger gibt in seinem Vortrag nützlich Tipps und konkrete Beispiele, um einen solchen Content-Wildwuchs entgegenzuwirken und eine saubere Informationsarchitektur zu etablieren.

Zu Beginn des Vortrags geht er auf die Bedeutung einer sauberen Content-Struktur und Informationsarchitektur ein. Also sonst mögliche Folgen nennt er:

- schlechte User:innen-Erfahrung und User:innen-Signale

- hohe Return-to-SERP-Rate

- Rankingverluste

Die erste und wohl wichtigste Frage, auf die Martin Höllinger eingeht lautet:

Wann lohnt sich eine eigene Seite für ein Thema?

Natürlich dann, wenn es das Thema auf der Website noch nicht gibt. Zusätzlich nennt er an dieser Stelle die Google-Search-Console als nützliches Recherche-Tool. Am besten sollte überprüft werden, welche Seiten hohe Impressionen, aber keine Klicks haben oder bei welchen Begriffen es nur zu kurzzeitigen Rankings kommt.

Die zweite große Frage im Vortrag war: Wie kann Content-Kannibalismus vermieden werden?

Als Hauptwerkzeug wird ein sauberer, vollständiger und aktueller Content-Plan genannt. Dieser beinhaltet alle bisherigen und weiter geplanten Themen. Bevor eine neue Seite erstellt wird, wird in diesem Plan geprüft, ob hierzu bereits etwas vorhanden ist. Weiter wird nochmal auf eine saubere interne Verlinkung und übersichtliche Navigation eingegangen.

Fazit: Für eine klare und Übersichtliche Informationsarchitektur sowie gute Nutzererfahrung sind somit folgende Kriterien essenziell:

- ein übersichtliches und logisches Menü, in dem sich Nutzer:innen gut zurechtfinden

- eindeutige Linktexte, die Nutzer:innen und Suchmaschinen durch die Seite leiten

- übersichtliche Content-Pläne und Nutzer:innen-Fokus auf den einzelnen Seiten

Was gibt es Neues seit der letzten SEOkomm?

Antigone Dyckhoff

In den letzten zwei Jahren seit der SEOkomm 2019 ist viel passiert. Die Welt veränderte sich durch Corona und mit ihr die Menschen. Das wiederum führte zu großen Veränderungen der Märkte, Zielgruppen und der Online-Welt. Diesen Entwicklungen veranschaulicht Antigone in einer emotionalen GIF-Story und zeigt anhand von spannenden Marktentwicklungen, wie die Digitalisierung durch Corona-Maßnahmen und Lockdowns angekurbelt wurde. Des Weiteren zeigt Antigone die Google-Updates von 2020 und 2021 auf und gibt hilfreiche Tipps und Tricks, um von den Updates zu profitieren.

Anschließend geht Antigone auf die technischen Änderungen wie bspw. die Deduplizierung von Featured-Snippets ein und erläutert die Änderungen auf den Suchergebnisseiten von Google.

Klingt interessant? Dann geht es hier weiter! Wir haben Antigones Vortrag Was gibt es Neues seit der letzten SEOkomm für euch noch einmal in einem separaten Artikel zusammengefasst.

SEO Canvas – Was SEOs von Produktmanagement lernen können!

Björn Darko

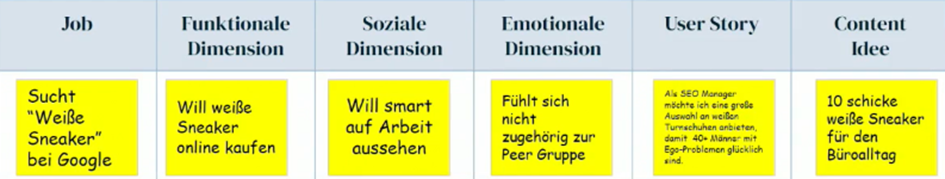

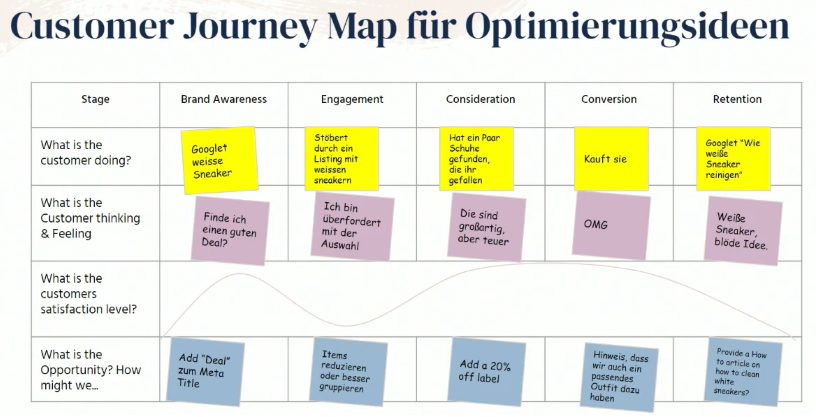

Oft beschäftigen sich SEOs hauptsächlich damit, wie sie Rankings generieren. Dabei stehen die Nutzer:innen jedoch nicht immer im Fokus. Anhand von etablierten Produktmanagement-Methoden & Frameworks zeigt Björn Darko, wie Nutzer:innen bei der Optimierung in den Fokus gelegt werden.

Ein wesentlicher Bestandteil im Produktmanagement ist das Verstehen der Nutzer:innen und deren Anliegen. Hinter jeder Suche steckt nämlich ein bestimmter Intent – job to be done genannt –, welcher zu einer Suche führt. Sein Beispiel für den Vortrag: Suche nach „weiße sneaker“.

Anschließend beschäftigt man sich im SEO-Canvas mit folgenden vier Fragestellungen:

- Für wen kreieren wir Value (Zielgruppe)?

- Wie generieren wir Value (Landingpage mit relevanten Produkten)?

- Wie liefern wir Value (genutzte Kanäle)?

- Wie fangen wir Value ein (Einnahmequellen)?

Im weiteren Teil des Vortrages geht es darum, die identifizierten Potenziale und Maßnahmen in eine Roadmap zu überführen und die gewonnenen Informationen für die letztliche Optimierung zu verwenden.

Fazit & Learnings

- Den job to be done der Nutzer:innen verstehen

- Roadmaps helfen bei Priorisierung

- SEO-Canvas für eine ganzheitliche Wertbetrachtung

- in Iterationen planen

- Customer-Journey-Mapping für neue Ideen nutzen

So nutzt Du die Google-Search-Console-API wie ein Profi - ohne zu programmieren

Stefan Fischerländer

Stefan zeigte in seinem Vortrag, welche Vorteile die API der Google-Search-Console bietet und wieso man diese nutzen sollte – und auch, wie es funktioniert.

So bestehen die Vorteile durch unter anderem folgende Punkte:

- mehrere Dimensionen kombinieren

- Export-Limit der 1.000 Zeilen umgehen

- verknüpfbar mit weiteren Datenquellen wie Screaming-Frog

- Datenspeicherung von über 1,5 Jahren in die Vergangenheit

Für die API-Anbindung hat Stefan Searchanalytics for Sheets erwähnt, allerdings darauf hingewiesen, dass es Open-Source ist und man nicht genau weiß, was damit gemacht wird. Alternativ stellte er seine kostenlose Software vor und würde liebend gerne Feedback erhalten, um sie weiterentwickeln zu können.

Hier könnt ihr sie finden: Fischerlaender.de/gsc > HTML zum Download (GSC-API mit Auswahlmöglichkeiten)

Stefan wies auf eine Besonderheit hin, die sehr interessant war: Die Summe der Querys ist immer höher, als wenn die Querys einzeln angesehen werden. Das liegt daran, dass nicht alle Querys angezeigt werden (aus Datenschutzgründen, da ansonsten bei Long-Tail-Keywords die einzelnen Nutzer:innen nachvollzogen werden könnten).

Innerhalb der Google-Search-Console können bis zu 1.000 Zeilen exportiert werden. Über die API können hingegen bis zu 50.000 Datensätze pro Tag abgerufen werden. Das bietet einen riesigen und praktischen Vorteil, da im Alltag eines SEOs die 1.000 Zeilen relativ schnell zu wenig sind. Um die Limitierungen weiter auszuhebeln, können einzelne Properties (wie Verzeichnisse) angelegt werden. So können je Property die Limits ausgereizt und insgesamt noch mehr Daten abgerufen werden.

Zudem können mit Hilfe eines eigenen Datensatzes schwierige Begriffe durch Soundex optimiert werden (zum Beispiel Städtenamen mit unterschiedlichen Schreibweisen).

Das große Ziel wäre, ein SEO-Data-Warehouse aufzubauen, indem unterschiedliche Datenquellen zusammenlaufen und so erweiterte Analysen ermöglichen. So auch die Verknüpfung der Sichtbarkeitswerte einzelner URLs mit der Häufigkeit der internen Verlinkung oder ähnliche aufschlussreiche Kombinationen.

Wie gewinne ich einen Enterprise-SEO-Pitch 2022

Paavo Spieker

Warum pitchen geil ist und wie man als SEO-Agentur Enterprise-Kunden gewinnen kann, zeigte Paavo Spieker in seinem Vortrag.

Dieser richtete sich an wachstumsambitionierte SEO-Agenturen mit mindestens drei Mitarbeiter:innen.

In seinem Vortrag beantwortete Spieker folgende Fragen:

- Warum ist ein Enterprise-SEO-Kunde besser?

- Macht es Spaß für einen DAX-Konzern SEO zu machen?

- Wie gewinne ich jeden SEO-Pitch bei einem (DAX-)Konzern?

Anhand einer einfachen Berechnung machte Spieker deutlich, dass die Betreuung von Enterprise-Kunden für Agenturen wirtschaftlich sehr interessant ist, und erzählte aus seiner Perspektive, wieviel Spaß es macht, für solche Kunden zu arbeiten.

Wirklich spannend wurde es, als Spieker exemplarisch den Ablauf eines Pitchs darstellte:

- Agentur-Auswahl

- Beauty-Contest

- Chemistry-Meeting

- Pitch-Briefing

- Einkauf-Schulterblick

- Pitch

- Party

Für Spieker ist es unerlässlich, gerade im Beauty-Contest ein Company-Slidedeck passend zur Branche und auf den Kunden optimiert zu erstellen.

Im sich anschließenden Chemistry-Meeting wird das Fundament hinsichtlich des gegenseitigen Vertrauens gelegt. Kommunikation ist der Schlüssel zum Erfolg. Daher gilt: fragen und zuhören, klären und einordnen, ob Empathie und DNA zwischen Agentur und Unternehmen stimmen. Seiner Erfahrung nach dauert ein solches Meeting 40 Minuten und setzt sich wie folgt zusammen:

- 5 Minuten stellt sich die Agentur vor. Wichtig war Pavo hierbei, zu erwähnen, dass Folien unter keinen Umständen vorgelesen werden sollten. Sie sind die Storyline. In diesen Bereich gehören Awards, das Team und die Historie der Agentur.

- 5 Minuten sollten auf SEO und fünf weitere Minuten auf Content verwendet werden. In diesem Teil des Chemistry-Meetings gilt es für jede Agentur, ihre SEO-Kompetenzen herauszustellen, aktuelle Trends und Entwicklungen aufzugreifen, News, belegbare Referenzen (Sistrix) aber auch Ausblicke auf die künftige Entwicklung der SEO zu geben. Dasselbe gilt es für den Bereich Content zu berücksichtigen. Spieker empfiehlt auf zehn Slides die Content-Kompetenz darzustellen, einen Content-Audit zu präsentieren, die Tools darzustellen, mit denen man arbeitet, aber auch hier das Team vorzustellen.

- 15 Minuten sollten auf die SEO-Analyse verwendet werden. Er hält es für unverzichtbar, die komplette Site-Clinic aufzuzeigen, dabei jedoch darauf zu achten, das Kunden-Inhouse-Team nicht dumm dastehen zu lassen (es sei denn, es war eine andere Agentur) und darzulegen, welche Probleme man sieht, die man bei einer Zusammenarbeit fixen würde. Auch macht es seiner Meinung nach Sinn, sämtliche Tools ins Feld zu führen und zu erklären, warum man mit diesen arbeitet.

- Abschließend sollten 10 Minuten auf Q&A verwendet werden.

Als Fazit gibt Spieker Folgendes mit: Jede Agentur sollte darauf achten, im Chemistry-Meeting ihre ganze SEO-Kompetenz zu zeigen, ohne dass es angestrengt wirkt. Es muss deutlich werden, dass SEO die Leidenschaft der Agentur ist, aber auch, dass die Agentur ihr SEO-Business zahlenmäßig voll im Griff hat.

Was sollte beim Pitchen im allgemein beachtet werden?

Essenziell für den Erfolg eines Pitchs ist das aufmerksame Bearbeiten des Pitch-Briefings der Kunden. So gilt es für die Agentur, auf alle Punkte der Leistungsbeschreibung der Kunden einzugehen und diese im Pitch ausführlich abzubilden.

Für den Pitch solle man eine Stunde einplanen. Gleich zu Beginn gab Spieker den Tipp, dass man als Agentur niemals die Visuals der Kunden nutzen solle, denn es gäbe immer jemanden, der die CI des Unternehmens besser kennt. Auch empfiehlt er, im Pitch stets nochmal das Unternehmen und das Team vorzustellen. Es kann immer passieren, dass jemand neu dazukommt. Ein Kardinalfehler sei es zudem, wenn Slides im Pitch übersprungen würden.

Der wichtigste Teil des Pitches sei seiner Erfahrung nach jedoch der Part Organisation. Für den Kund:innen gilt die Agentur als verlängerte Werkbank, mit der das Corporate-Leben einfach besser ist. Daher muss in jedem Pitch darauf eingegangen werden, wie der Workflow mit dem Kunden aussehen wird.

Diese Punkte sind für SEO im Pitch relevant

Wichtig sei es, die SEO-Mission in den Vordergrund zu rücken. Hier gilt es, den Kunden zu veranschaulichen, was man in den ersten zwölf Monaten mit ihm erreichen möchte und zu verdeutlichen, dass man bereit ist, seinen Internetauftritt zu optimieren.

Da gerade Enterprise-Kund:en datengetrieben arbeiten, sei es unerlässlich, im Pitch bereits ein vollautomatisiertes KPI-Dashboard zu zeigen, welches die Reportings für alle Länder und Stakeholder entsprechend abbildet. Zudem solle man hervorheben, dass man für alle Tools offen ist und zeigen, dass man Partnerschaften mit allen SEO-Tools hat. Auch im Bereich des technischen SEOs gilt es, die interne IT des Kunden abzuholen und zu erläutern, was die Zusammenarbeit mit der Agentur für sie bedeutet. Sofern Tech-Kompetenz auf Seiten der Agentur vorhanden ist, so sollte diese in jedem Fall zum Ausdruck gebracht werden.

Hinsichtlich des Content-Parts muss die Agentur beweisen, dass sie die Pitch-Aufgabe zu 100 Prozent verstanden hat und sich so tief in die Marke reingedacht hat, dass sie sofort starten können. Eine ausgearbeitete Storyline und ein roter Faden müssen seiner Erfahrung nach vorliegen. Er empfiehlt zudem Design-Mockups bis ins kleinste Detail vorzubereiten. Ein in seinen Augen vernachlässigtes Thema, dass aber gerade bei großen Brands eine hohe Relevanz innehält, sei Voice-Search, was man anhand eines Beispiels im Pitch unterbringen sollte.

Weitere Pitch-Empfehlungen

Viele Agenturen scheuen sich, in einem Pitch der Frage nach den Kosten zu stellen. Doch laut Spieker beginnt schon oft während des Pitches die Preisverhandlungen mit dem Einkauf. Sein Tipp ist, mit einem Preisblatt zu arbeiten, auf dem verschiedene Levels abgebildet werden. Er rät Agenturen, sich immer im Durchschnitt von 1.000 € PT zu positionieren.

Damit der Pitch auch das enthält, was für den Kunden wichtig ist, sollte vorab ein Schulterblick gemacht werden. Hier wird der gesamte Pitch mit der Fachabteilung des Kunden durchgegangen. Dabei ist es von grundlegender Bedeutung, dass die Agentur zuhört und Fragen stellt. Zu viele Fragen gibt es nicht.

Ein Pitch sollte, so möglich, immer vor Ort beim Kunden stattfinden. Um technische Probleme zu vermeiden, sollte die Pitch-Präsentation in allen möglichen Formaten vorenthalten sein. Die Agentur sollte vorsichtshalber alle Adapter mitnehmen und vor allem richtig gute Laune mitbringen.

Nach zehn Tagen sollte man beim Kunden nachfragen, ob er überzeugt werden konnte. Sagt er zu, kann die Maschinerie des Eigenmarketings starten. Außerdem kann beim Kunden um Erlaubnis für eine Pressemitteilung gebeten werden, sodass der Erfolg über alle Kanäle gestreut werden kann.

Core-Vital-Speed-Performance-Score CRUX Lab-Field-Experience-Data-Light- oder Darkhouse?

Prof. Dr. Mario Fischer

Google ist ständig in Bewegung und ändert seine Performance-Metriken ständig. Prof Dr. Mario Fischer zeigte in seinem Vortrag Beginnern und Fortgeschrittenen auf, wie all das zusammenhängt, wo die Stolperfallen liegen und wie wichtig die neuen Daten tatsächlich zu nehmen sind. In seinem Vortrag widmete er sich folgenden Fragestellungen:

- Sind kleine und mittlere Unternehmen mit den vielen Metriken von Google überfordert?

- Wie werden sich die Performance-Metriken weiterentwickeln – wann werden sie so wichtig sein, dass man ohne nicht mehr gut ranken kann?

- Findet aktuell nicht sogar ein übertriebener Hype bei SEO-Agenturen statt, die Ihren Kunden mit neuen Optimierungen neue Rechnungen schreiben möchten?

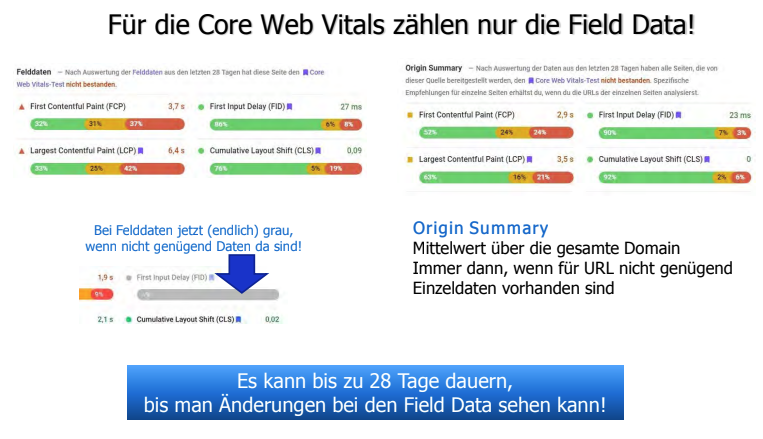

Zu Beginn seines Vortrages ging Dr. Fischer auf die Aussagen von Google zu der Thematik ein, wonach deutlich wird, dass, wenn keine Feld-Daten einer Website erhoben werden können, auch keine CWV-Score-Kalkulation möglich ist und sie somit auch keine Rankingfaktoren für die URL sind. Die Frage, wie dann innerhalb der Suchmaschinen Ergebnisseiten verglichen werden können, führe folglich zu maximaler Verwirrung bei all denjenigen, die im technischen SEO nicht fit sind.

Rankingsignale bei Google: Core-Web-Vitals

Aus diesem Grund ging Prof. Dr. Fischer im nächsten Teil seines Vortrages auf die Ranking-Signale ein, die seit dem 2. September 2021 gültig sind.

- LCP (Largest Contentful Paint) / wahrgenommene Ladegeschwindigkeit: die Zeit vom Beginn des Ladestarts der Seite bis zum fertigen Rendern des größten Inhaltselements im Sichtbereich

- FID (First Input Delay)/ Nutzererfahrung: zeigt an, wie schnell die Reaktion auf die erste Nutzeraktion ist

- CLS (Cumulative Layout Shift) / visuelle Stabilität: zeigt an, wie “stabil“ sich das Layout verhält und wie stark visuell (unerwartete) Änderungen sind, wenn sich etwas auf der Seite ändert

Gerade der LCP macht häufig Probleme, da es pro Seite zunächst mehrere LCP-Werte geben kann, was jedoch von der Ladereihenfolge abhängt. Das Problem hierbei ist, dass immer das größte Element zählt und am Ende der letzte LCP.

Als Quick-Lösung gab Dr. Fischer folgende Vorschläge an:

- bestimmen, welches Element der LCP ist

- Überprüfung, ob Bilder wirklich die große Auflösung benötigen

- Slider sind zu vermeiden

Bei zunächst verdeckten Inhalten gelte es, Bilder ggf. erst später nachzuladen um ein anderes Element zum LCP zu machen.

Er machte zudem darauf aufmerksam, dass es beim LCP nicht nur um Schnelligkeit, sondern auch um Volumen geht.

Beim FID wird die Zeit gemessen, bis die Seite nach einer Interaktion “reagiert”. Dies können Taps, klicks oder die Tastatureingabe sein. Scrollen hingegen wird nicht gewertet. Er stellte heraus, dass es beim FID nur um die erste Input-Verzögerung geht und es diesen Wert ausschließlich als Field-Data gibt. Daher riet der Referent dazu, als Wert nach dem TBT (total blocking time) zu schauen.

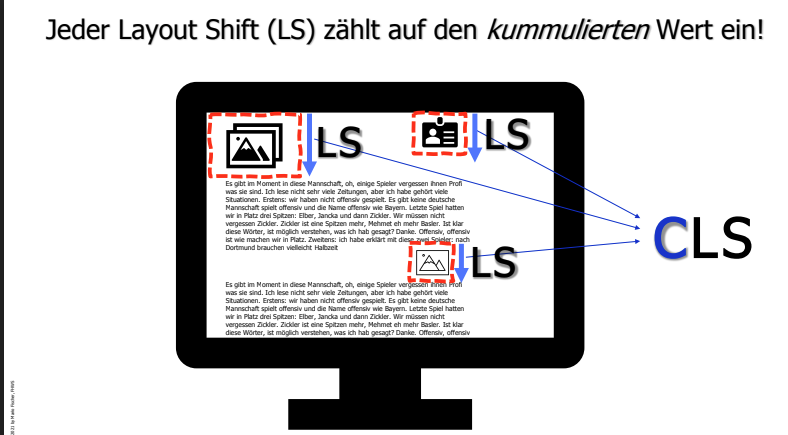

Beim CLS zahle jeder Layout-Shift auf den kumulierten Wert ein, wohingegen Shifts außerhalb des sichtbaren Bereichs ok seien.

Als Lösungen für das Gros der CLS bieten sich an:

- Inline-Dimensionen für Bilder hinterlegen

- Inline-Dimensionen für iframes hinterlegen

- Platzhalter für dynamische Contentelemente

Seiner Aussage nach lassen sich 80 Prozent der Probleme der Core Web Vitals mit 20 Prozent Aufwand lösen, indem man Bilder komprimiert. Sollte dies nicht zum gewünschten Erfolg führen, so wären die nächsten Schritte:

- JavaScript überprüfen

- CSS bereinigen

- unnötige DOM-Elemente entfernen

- prüfen, ob Elemente von Drittanbietern reduzierbar sind.

Prüfen der Core-Web-Vitals

Alsdann seien die Core-Web-Vitals mit einem Tool (PageSpeed) zu überprüfen. Die Krux daran ist, dass nur das 75. Perzentil gewertet wird, was bedeutet, dass drei Viertel aller Messungen beispielsweise im Bereich “gut” liegen, damit insgesamt ein “gut” ausgegeben wird. Weiterhin beinhaltet die Auswertung neben den Core-Web-Vitals LCP, FID und CLS auch die Lab-Daten TTI, TTB, SI und FCB, die angeblich keine Rankingfaktoren sind. Für die Core-Web-Vitals zählen jedoch nur die Felddaten.

Auf Core-Web-VItals zu optimieren, lohnt sich laut Prof. Dr. Fischer immer bei:

- roten Werten, um so die Nutzererfahrung positiv zu gestalten

- einem Seitenranking auf Seite 1 der SERPS in den Positionen 3 bis 6. Hier könne ein Push um nur eine Position den Traffic teilweise vermehrfachen. Hierbei gilt es, sich nur mit dem unmittelbaren Mitbewerbern in einer Keyword-Serp zu vergleichen.

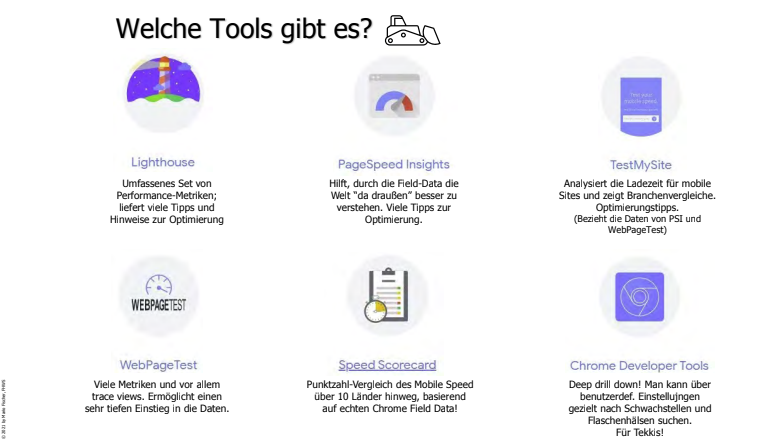

Um an die benötigten Metriken heranzukommen, empfielt der Referent neben Pagespeed-Insights die Google-Search-Console, den Chrome-Browser mit seiner Entwicklerkonsole oder das Browser-Plugin HUD (Head Up Display) oder das CrUC-Dashboard für Google-Data-Studio (https://web.dev/chrome-ux-report-data-studio-dashboard/), aber auch gtmetrix.com.

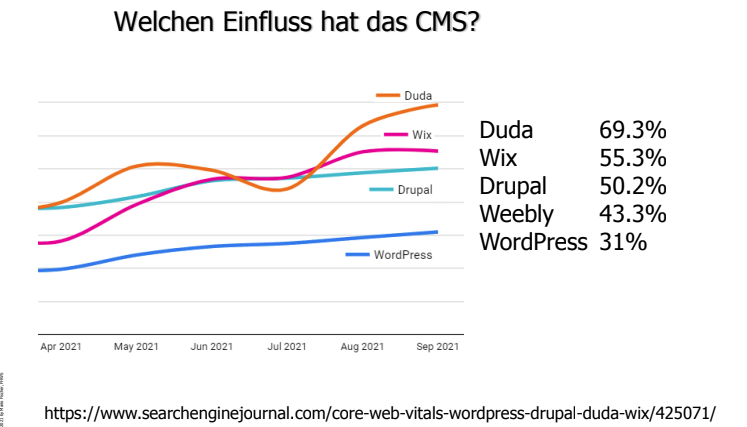

Zuletzt verwies Prof. DR. Mario Fischer darauf, dass das verwendete CMS Einfluss auf die Core-Web-Vitals hat.

SEO-Experimente richtig machen

Leonard Becker

Mit SEO-Experimenten waren im Vortrag von Leonard Becker in erster Linie A/B-Tests gemeint und, welche Veränderungen auf den Webseiten getestet wurden.

Zunächst sollte man sich bei einem Experiment überlegen, aus welcher Motivation man einen Test startet. Also sollte eine Hypothese aufgestellt, das Testszenario inklusive KPI konstruiert, einen Zeitraum festgelegt und die Testgruppe zusammengesetzt werden.

Hierbei muss unterschieden werden, aus welchen Gründen SEOs im Gegensatz zu Produktmanager oder Websiteowner einen Test erstellen. Während Letztere auf A/B-Test, die Client-Side und gruppierte Nutzer:innen setzen, ist die Motivation im Bereich SEO eine andere. Hier stehen SEO-A/B-Tests, die Server-Side und die Gruppierung von Seiten im Vordergrund.

Voraussetzungen für A/B-Tests

Zwei wichtige Voraussetzungen müssen dabei auf jeden Fall gegeben sein:

- Es müssen Templates verwendet werden, damit Unterschiede auf einer identischen technischen Basis getestet werden können.

- Der Traffic der getesteten Bereiche sollte idealerweise auf über 100 Entries pro Gruppe und Tag kommen. Darunter ist die Signifikanz der Daten nicht gegeben.

Leonard zeigte anschließend ein paar Ideen auf, für die sich ein SEO-Experiment lohnt:

- Tags

- Headlines

- semantische Auszeichnungen

- interne Verlinkung

- Sitemaps

Um eine Übersicht zu haben, ist es hilfreich, wenn ein Experiment-Canvas erstellt wird.

Zu den Testgruppen gab Leonard auch viele nützliche Hinweise. Die Gruppen dürfen auf keinen Fall zufällig gewählt werden, sondern müssen sich so ähnlich wie möglich zusammensetzen. Dies gilt für die einzelnen Testgruppen und auch für die Kontrollgruppen. Die Zusammensetzung gilt für alle demografischen Merkmale, Altersgruppierungen, Messzeitpunkte und Masse der Nutzer:innen.

Nach weiteren Tipps zu verschiedenen Auswertungsmethoden, wie z. B. der DD-Methode oder der Casual-Impact-Methode wurden noch ein paar interessante Tests aus der Kununu-Welt präsentiert.

Hier war auffällig, dass z. B. ein Test mit 20 Firmenprofilen sehr gute Ergebnisse, aber nur eine geringe Signifikanz aufzeigte, da es sich hier um usergeneratet Content handelte.

Für einen weiteren Test wurde die Hypothese aufgestellt, dass eine Reduktion des Contents bestimmter Seiten wohl einen hohen Trafficverlust bedeuten würde. Dies wurde von Entscheidern als reine Theorie abgestempelt. Nach vier Wochen Tests mit signifikanten Bedingungen konnte bewiesen werden, dass rund 40 Prozent weniger Traffic auf den getesteten Seiten im Vergleich zur Kontrollgruppe erzielt wurden.

Als letzten Tipp konnten wir noch mitnehmen, dass sich durch SEO-Tests Aussagen von anderen SEOs überprüfen lassen oder die Produktentwicklung sehr gut unterstützt wird.

Featured-Snippets + Rich-Results: CTR-Booster oder Gefahr?

Markus Hövener

Markus Hövener beleuchtet die altbekannten Themen Featured-Snippets und Rich-Results noch einmal von verschiedenen Seiten. Schnell wird klar, dass es jeweils Vor- und Nachteile gibt, derer man sich bei der Optimierung bewusst sein muss.

Featured-Snippets

Früher auch Position Null genannt, brachten die Featured-Snippets den großen Vorteil mit sich, dass die für eine Dopplung auf den SERPs sorgten. Heute ist dem nicht mehr so. Wird ein Featured-Snippet ausgespielt, wird die Ergebnisseite nicht noch ein zweites Mal weiter unten gezeigt, sondern „nur“ als Position 1 ausgespielt.

Featured-Snippets werden bei ca. 20 Prozent der Suchanfragen ausgespielt. Sie sind allerdings nur sinnvoll, wenn auch tatsächliche Antwort existieren. Damit ist gemeint, dass die gesuchte Information als Text, Liste oder Tabelle dargestellt werden kann. Dies ist z. B. bei vielen transaktionalen Suchanfragen nicht der Fall.

Obwohl Featured-Snippets zwar mehr Platz in den Suchergebnissen einnehmen, werden sie dennoch weniger geklickt. Eine niedrigere CTR, im Vergleich zu regulär dargestellten Ergebnissen auf Position eins, ist die Folge. Denn vielen Nutzer:innen genügen die ausgespielten Informationen, ein Klick ist für sie nicht notwendig. Ein ähnliches Problem ergibt sich auch mit Blick auf Voice-Search. Featured-Snippets werden hier zwar vorgelesen, was auch erst einmal gut ist, dieses Auslesen der Information kann allerdings nicht gemessen werden.

Trotz kreierter Jump-Links können Klicks auf Featured-Snippets nicht ausreichend gut von normalen Klicks unterschieden werden. Sie können zwar die Brand-Awareness steigern und auch Klicks generieren. Durch die fehlende Messbarkeit sind Featured-Snippets laut Markus Hövener allerdings mit Vorsicht zu betrachten. Man muss hier genau prüfen, wann dieses Format den Search-Intent gut abdeckt.

Rich-Results

Der größte Unterschied zwischen Rich-Results und Featured-Snippets ist, dass für Rich-Results ein Markup-Code erforderlich ist. Ist der richtige Inhalt auf einer Seite vorhanden, so kann über das Markup ein Rich Result kreiert werden. Das Anzeigen von Bewertungssternen, der Telefonnummer oder Events sind hier nur einige der vielen Möglichkeiten, ein Snippet zu erweitern. Die Nutzung des Markups bringt allerdings nicht nur den Vorteil der Rich-Results mit sich. Sie ermöglicht auch ein Ausspielen über andere Google-Anwendungen wie z. B. Job Search.

Doch auch die Rich-Results bringen Hürden mit sich. Eine Vergleichbarkeit von verschiedenen Markups ist nur über Kontrollgruppen und Vorher-Nachher-Vergleiche möglich. Und auch bei den Rich-Results kann es laut Markus Hövener zu einem Rückgang der CTR kommen. Dies kann auch hier daran liegen, dass Nutzer:innen bereits alle Informationen auf den SERPs erhalten haben. Doch auch Sternebewertungen, die als nicht gut genug bewertet werden, können zu sinkenden Klickzahlen führen.

Markus ruft an dieser Stelle dazu auf, immer an die Nutzer:innen zu denken, denn nicht das Markup gewinnt, sondern der Inhalt. Wer blind Rich-Results kreiert, ohne die Intention der User:innen zu beachten, wird keine nachhaltigen Erfolge durch die Markups erzielen können.

Zusammenfassend bezeichnet Markus Hövener Featured-Snippets und Rich-Results als zweischneidige Schwerter und rät dazu, sich beim Einsatz gezielt Gedanken zu Intention und Outcome zu machen.

Auf dem Bild zu sehen: Markus Hövener

Core-Web-Vitals - Beyond the basics

Maximilian Schirmer

Mit einem kurzen Browser-1×1 leitet Maximilian Schirmer seinen Vortrag zu den Core-Web-Vitals ein und holt so noch einmal alle Zuschauer:innen ab, bevor er sich mit den Themen Consent-Management-Platform, CSS-Dateien und JavaScript-Timing beschäftigt.

CMP - Consent Management Platform

Häufig lässt es sich nicht umgehen: Der Cookie Banner muss ausgespielt werden und wird so zum Largest-Contentful-Paint. Maximilian zeigt hier aber gleich mehrere Möglichkeiten auf, den Ladeprozess zu verbessern. Unter anderem können einzelne Ressourcen über Preload geladen und die Sprache fest angegeben werden, sodass sie nicht erst vom Browser angefragt werden muss.

CSS-Dateien

Viele Websites laden alle CSS-Ressourcen direkt. Maximilian rät dazu, sich auf das Critical-CSS zu fokussieren. Das Critical-CSS wird auf den initialen Viewport angewendet und muss daher sofort geladen werden. Das DOM-CSS – und somit die größere CSS-Datei – wird allerdings erst später vom Browser benötigt und kann daher nachgeladen werden. Es lohnt sich vor allem, auch einen genaueren Blick in die Datei zu werfen, denn das DOM-CSS sollte so optimiert werden, dass es nur wirklich relevante Informationen für die jeweilige URL beinhaltet.

JavaScript-Timing

Nicht nur Third-Party-JavaScript kann zu langen Ladezeiten führen, auch das eigene JavaScript kann Probleme erzeugen. An einigen Beispielen zeigt Maximilian auf, wie durch die Anpassung des Timings JavaScript-Dateien so nachgeladen werden können, dass sich die Ladezeit verringert, die Websitefunktionen aber nicht eingeschränkt sind. Wird JavaScript für das Suchfeld oder Widgets auf einer Seite benötigt, so reicht es, diese JS-Dateien dynamisch nachzuladen, sobald der Cursor z. B. über das Suchfeld bewegt wird. Auch der Google-Tag-Manager sollte erst später getriggert werden.

Zwischen vielen Tipps, Tricks und Beispielen rät Maximilian Schirmer vor allem dazu, sich ganz allgemein auf das Priorisieren der zu ladenden Ressourcen zu konzentrieren. Zu Anfang soll nur geladen werden, was auch wirklich benötigt wird. Alle weiteren Ressourcen können über verschiedene Möglichkeiten wie z. B. Lazy-Load und After-Load nachgeladen werden.

Zum Abschluss hat Maximilian noch sieben schnelle Core-Web-Vitals-Tipps dabei, welche lauten:

- Nutzung des Tools WebPageTest.org

- JavaScript nicht im Footer, sondern im Header laden und deferren

- CDN als Reverse-Proxy

- kurze CMP, kein LCP-E

- kein Lazyload above-the-fold

- Nutzung des Tools webspeedtest.cloudinary.com

- Nutzung von Chromes Web-Vitals-Overlay

Auf dem Bild zu sehen: Maximilian Schirmer

Google-Indexmanagement Extreme

Darius Erdt, Jan-Peter Ruhso

Webseiten und deren Inhalte können nur ranken, wenn sie denn auch indexiert werden. Zudem kommen die Faktoren Technik und Qualität hinzu, damit Google diese Seiten erreichen und für ein Ranking in Betracht ziehen kann.

Technik

Darius und Jan-Peter zeigten zuerst auf, wie der Google-Algorithmus mit Hilfe von Caffine Inhalte in die SERPs übernimmt. Als Konklusion kam heraus, dass ein schnelles Crawling auch zu schnellen Rankings verhelfen kann. Von daher sollte man immer eine grundlegende Indexierungsstrategie erstellen.

Zuerst gilt es zu überprüfen, ob das Crawling sauber abläuft. Dies geschieht am schnellsten mit der Google-Search-Console und Logfileanalysen. Hat man herausgefunden, dass wichtige Seiten nicht indexiert werden, bzw. eine erhebliche Menge an unwichtigen Seiten den Index füllen, werden die gängigen Methoden angewandt, um hier nachzujustieren.

Diese Methoden haben die beiden Referenten mit ihren Vor- und Nachteilen erläutert:

- robots.txt

- meta tag robots

- x-robots tag

- Canonicals

Anschließend wurde über das Crawlbudget gesprochen. Im Grunde müssen sich die meisten Seitenbetreiber keine allzu großen Sorgen machen. Wichtig ist hierbei vor allem, dass 500er-Fehler und Soft-404er vermieden werden und man sich den Einsatz von Canonicals genau überlegt. Im Grunde müssen alle wichtigen Seiten für das Ranking gut auffindbar sein, der Rest kann getrost blockiert werden.

Qualität

Für die Indexierung wurden im Vortrag die Qualitätsfaktoren kurz angerissen. Zusammengefasst lässt sich sagen, dass folgende Faktoren hier einen Einfluss nehmen:

- Core-Web-Vitals

- Mobile-Friendlyness

- Safe-Browsing

- HTTPs

- Vermeidung von Intensive-Interstitials

Im Folgenden wurde erklärt, wie man ein Crawling durch Google anstoßen kann. Insbesondere die nachstehenden drei Methoden haben sich immer bewährt:

- Erstellung einer XML-Sitemap

- prominente Verlinkung neuer Inhalte auf Seiten, die oft gecrawlt werden

- mittels Google-Search-Console

Deindexierung

Aber wie sieht es aus, wenn Inhalte deindexiert werden müssen? Auch dafür hatten Darius und Jan-Peter einige Ideen dabei. Diese haben Sie an hypothetischen (in der Realität aber ständig vorkommenden) Beispielen gezeigt. Darunter war z. B. die Situation, dass oft Seiten im Index bleiben, obwohl diese auf “noindex” stehen. Das Problem daran ist, dass diese Seiten offensichtlich nicht gecrawlt werden. Um einen Crawl anzustoßen, kann man eine zusätzliche XML-Sitemap erstellen. Sobald man aber feststellt, dass die Inhalte deindexiert werden, sollte man diese Sitemap wieder entfernen, um eine Reindexierung zu vermeiden.

Bietet die Deindexierung “unwichtiger” Inhalte eigentlich einen nennenswerten Business-Impact? Oft lässt sich die Frage mit “Nein” beantworten. Eher wird die Deindexierung wichtig, wenn man mit Duplicate-Content zu kämpfen hat oder aber durch erreichbare Inhalte eine Abmahnung droht.

Falls man die Inhalte nicht selbst entfernt bekommt, obwohl man Onsite alles richtig gemacht hat, kann man sich noch der folgenden Methoden bedienen:

- URL-Entfernungs-Tool in der Search-Console

- Bulk-URL-Removal für Google Chrome

- Tool zum Entfernen von alten Inhalten (auch über die Search-Console im Hilfebereich erreichbar)

Wichtig: Wenn die Ursache für die fälschliche Indexierung nicht entfernt wird, werden die Inhalte nach kurzer Zeit wieder im Index landen.

Zuletzt wurde der Vortrag noch durch ein Beispiel abgerundet, dessen Ergebnis war, dass von 800 zu indexierenden URLs 700 am nächsten Tag im Google-Index auftauchten und 95 Prozent der Seiten dauerhaft geblieben sind.

Wie Google funktionieren könnte: Was ich aus 20 h Gesprächen von John, Martin und Gary gelernt habe.

Johan von Hülsen

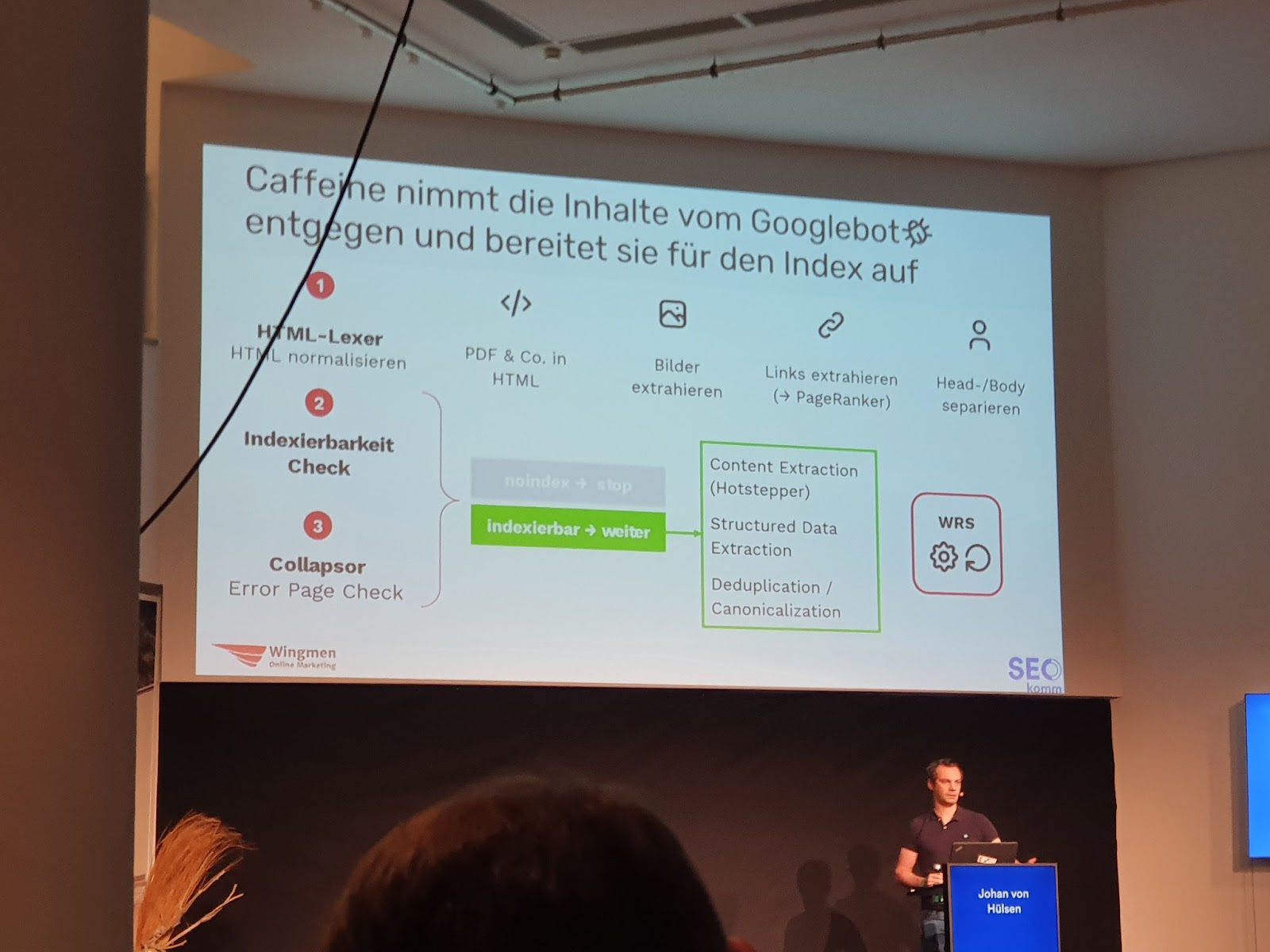

Johan hat in seinem Vortrag detailliert vorgestellt, wie er die Verarbeitung von Websiten durch den Google-Bot annimmt. So erwähnte Johan, dass nicht die ganzen HTML-Dokumente 1 zu 1 im Index bei Google liegen – wieso sollten dort auch zig Mal die gleichen Navigationssysteme einer Seite hinterlegt sein? Vielmehr werden die relevanten Informationen extrahiert und systematisch aufgenommen.

Hierbei ging er unter anderem auf die genaue Verarbeitung von Caffeine ein, dem Indexierung-System von Google. So sollen drei Schritte existieren, welche lauten:

- HTML – Lexer (HTML normalisieren)

- Indexierbarkeitscheck

- Collapsor (Error-Page-Check)

Der HTML-Lexer ist wichtig, da fast keine Webseite ein sauberes HTML aufweist. Zunächst wird der Code dadurch geglättet und gesäubert. Dazu gehört, PDF & Co. in HTML umzuwandeln, die Bilder zu extrahieren, die Links zu extrahieren (PageRanker) sowie den Head und Body zu separieren.

Anschließend folgt der Indexierbarkeitscheck und Check der Error-Pages. Diese beinhalten die Themen Conten- Extraction, Structured-Data-Extraction und Deduplication/Canonicalization.

Bei der Deduplication und Canonical-Identifizierung werden drei Schritte unterschieden:

- Cluster bilden

- Canonical-URL für Cluster definieren

- Canonical repräsentiert Cluster

Es zeigte sich insgesamt, dass der Indexierungsprozess wesentlich komplexer und tiefgreifender ist und sich einem eigenen Schema bedient, in dem alles in HTML umgewandelt wird und lediglich die relevanten Informationen extrahiert werden.

Auf dem Bild zu sehen: Johan von Hülsen

Serverless SEO: Ein Hands-on-Guide

Bastian Grimm

Bastian stellte die Möglichkeit vor, Änderungen (vor allem für die Suchmaschine) ohne Eingriff in das HTML vorzunehmen. Dafür wird quasi zwischen Server und Crawler eine neue Ebene geschaltet, welche die Änderungen darüber legt und die Suchmaschinen-Crawler das Ganze entsprechend aufnehmen.

Dabei ist den Änderungen kaum ein Limit gesetzt. Durch Serverless SEO können zahlreiche Faktoren wie Inhalte, Robots-Anweisungen, Meta-Daten etc. schnell angepasst werden. Üblicherweise wird der Code direkt auf dem Server bearbeitet und enthält dadurch das Risiko, dass durch SEO-Veränderungen die Funktionalitäten der restlichen Seite beeinträchtigt werden.

Für Bastian gehört Serverless SEO die Zukunft. Der schnelle und variable Zugang bietet ebenso eine gezielte Ausspielung der Elemente. So kann den Anforderungen des:der Nutzers:Nutzerin auf Serverseite und den Anforderungen der Suchmaschinen auf der anderen Ebene separat und gezielt abgebildet werden.

Drei entspannte Gedanken zu SEO

Karl Kratz

„Professionelles Gezocke gegen eine Blackbox auf der Basis von Glück, Werkzeugen und Erfahrung.“ Das ist die etwas andere Definition der Suchmaschinenoptimierung von Karl Kratz. Ihm geht es nicht nur darum, auf Platz eins bei Google zu ranken. Für Karl ist eine systemübergreifende, digitale Findbarkeit ausschlaggebend für den Marketingerfolg der Zukunft.

Zu den folgenden drei SEO-Themen hat Karl seine entspannten Gedanken zur SEOkomm mitgebracht und die Zuschauer:innen zum Nachdenken angeregt:

1. Das digitale Spielfeld und die Diversifizierung

Eine Diversifizierungsstrategie ist heutzutage unerlässlich. Denn was passiert, wenn eine Plattform stirbt und ich nur auf diese gesetzt habe? Um das Risiko zu minimieren, muss mehrgleisig gefahren werden. Die Optimierung für nur eine Plattform reicht nicht mehr aus.

2. Fokussierung, Reduktion, Intensivierung

Ausmisten, ausmisten, ausmisten! Das ist für Karl unerlässlich, denn weniger Seiten mit besserer Qualität sind für ihn das Ziel. Dabei muss sich auf relevanten Content fokussiert werden. Dieser wird intensiviert, also kontinuierlich verbessert und ausgebaut, während irrelevanter Content ganz einfach gelöscht wird.

3. Sequenzielle Handlungen in Prozesse umwandeln

Karl sieht viel Potenzial darin, sequenzielle Aktivitäten in dauerhafte, optimierbare Prozesse umzuwandeln. Er stellt sich hierbei die Frage: Wie viele und welche Inhalte brauche ich wirklich, damit Conversions stattfinden können? Vor allem blindes Bloggen und versenden von Newslettern prangert Karl hierbei an. Er definiert das Ziel wie folgt: Einmal-Traffic muss so wirksam wie möglich in steuerbaren Mehrfach-Traffic umgewandelt werden. Der richtige Content hilft dabei, während irrelevanter Content nur im Weg umgeht.

Nach diesen drei Gedanken ruft Karl Kratz noch einmal zu Content-Testing und der daraus resultierenden kontinuierlichen Transformation digitaler Inhalte auf. Die letzte Frage, die er dem Publikum dabei zum Nachdenken mitgibt, ist: Wie können wir Content erlebbarer machen?

Als Denkanstoß hat er noch ein Erfolgsbeispiel aus seinem Daily-Business dabei. Per Video gibt er hier abschließend einen Einblick in die gezielte Erstellung von erlebbarem Content. Konkret in die Idee, langweiligen Website-Content für eine Lackiererei in ein spannendes und erlebbares virtuelles Modell umzuwandeln.

Auf dem Bild zu sehen: Karl Kratz

How to train your SEO

Natascha Schindler

In ihrem Vortrag “How to train your SEO” gab Natascha Schindler einen Einblick, wie sie in der Agentur Waldhirsch Trainees in zwölf Monaten so ausbildet, dass alle genug Fachwissen und fachliches Selbstbewusstsein haben, um intellektuelle Risiken einzugehen.

Nach einem Exkurs darüber, in welcher Umgebung Menschen lernen, stieg Schindler direkt in das Thema ein.

Zunächst stellte sie die Frage, nach dem “Warum” und zielte damit auf die Motivation der Unternehmen hinsichtlich der Nachwuchsausbildung und ihre Motivation als Lehrende als auch auf die der Trainees als Lernende ab.

Dass Trainees das Handwerkszeug des SEO lernen müssen, ist nachvollziehbar. Schindler unterteilt die Wissensvermittlung in drei Säulen:

- Definitionen, die das Grundvokabular für eine gemeinsame Sprache bilden

- Konzepte, die verstanden werden müssen und nicht durch stures Auswendiglernen begriffen werden können

- Prozesse, die geübt werden müssen

Als nächstes hinterfragte sie, wie Wissen vermittelt werden muss. Für sie stellten sich hierbei die Fragen nach den Ressourcen, auf die zurückgegriffen werden kann, wie Fragen geklärt werden und der Erfahrungsaustausch zum Gelernten stattfindet kann.

Als nächstes ließ die Referentin das Auditorium an ihrem Trainee-Prozess teilhaben. Sie untergliedert diesen in vier Schritte:

- Vorbereitung: Pro Woche wird ein Thema bearbeitet. Zu diesem Thema erhalten die Trainees Fachinhalte, die sie vorbereiten sollen

- Coaching: Theoretische Inhalte werden an Praxisbeispielen gezeigt und greifbar gemacht. Unterstützende Tools helfen beim Verständnis.

- Aufgabe: Passend zu den theoretisch gelernten Inhalten werden eigenständig Aufgaben umgesetzt.

- offene Fragerunde: Das ist ein freiwilliges Angebot, bei dem es darum geht, gemeinsam Lösungen zu finden. Der Vorteil der Fragerunde liegt für Schindler in der Stärkung des Selbstbewusstseins und der Überprüfung des Lernfortschritts.

Dabei betont die Referentin die Wichtigkeit, Erwartungshaltungen an Verfügbarkeit und Arbeitsergebnisse unmissverständlich zu kommunizieren. Weiterhin machte sie in ihrem Vortrag deutlich, dass es für ein erfolgreiches Traineeship des vollen Einsatzes des Lehrenden bedarf. Der Lehrende muss alles dafür tun, um den Lernprozess zu unterstützen, sei es durch einen permanenten Abgleich der erbrachten und erwarteten Leistung, durch Feedback oder aber auch der Schaffung einer positiven Fehlerkultur.

Der Vortrag war in Summe ein gelungener und sehr interessanter Einblick in die Ausbildung von Nachwuchskräften.

Auf dem Bild zu sehen: Natascha Schindler

SEO-Patterns: Typische Website-Probleme und deren Lösungen

Markus Hövener

Egal wie individuell Websites mittlerweile sind, wer schon die ein oder andere Seite analysiert hat, stößt immer wieder auf ähnliche Probleme. In seinem Vortrag zeigt Markus Hövener typische SEO-Patterns und gibt Tipps, diese aus SEO-Sicht optimal umzusetzen.

Pattern 1 - Paginierung funktioniert nur mit Links

Für die Umsetzung der Paginierung gibt es unterschiedliche Lösungen: Infinite-Scrolling, den Button “Mehr laden” oder die klassischen Seitenlinks (weiter & zurück). Damit die Paginierung auch für SEO funktioniert und weiterführende Seiten bzw. Inhalte von Google gelesen werden können, benötigt es Links. Ein Button ohne hinterlegte URL wird nicht gecrawlt und folglich auch nicht die dahinter verborgenen Inhalte.

Pattern 2 - Produktvarianten (betrifft hauptsächlich Webshops)

Viele Produkte gibt es in unterschiedlichen Varianten (Länge, Farbe, etc.). Auch hier gibt es unterschiedliche Lösungen.

- Variante mit eigener URL → z.b. product?var=blau

- Variante ohne eigene URL → z.b. product/#variationId=67066

Besonders durch Varianten mit eigener URL kann so schnell eine Menge Duplicate-Content entstehen.

Seine Empfehlung: In der Regel werden Varianten nicht indexiert. Es gibt ein Hauptprodukt bzw. eine Hauptvariante, welche im Index gefunden wird. Die anderen Varianten werden entweder auf die definierte Hauptvariante oder das Produkt kanonisieren. Wird für eine bestimmte Variante Suchvolumen verzeichnet, kann diese nachträglich indexiert werden.

Pattern 3 - Metadaten bei großen Websites

Aufgrund der hohen Seitenzahl sind Metadaten oft: leer, uneinheitlich, irrelevant, Dubletten, etc.. Entsprechend gehen Klickpotenziale verloren.

Empfehlung: Mit Schablonen Title automatisiert optimieren. Zum Beispiel wird so für alle Produktseiten in einem Onlineshop definiert, dass der Title sich wie folgt zusammensetzt:

[Kategorie] online bestellen | Brand

Pattern 4 - URL-Parameter

URL-Parameter können schnell zu einer sehr hohen Menge an zusätzlicher URLs führen. Ein Beispiel sind Parameter bei Filtern: Je Variante und Kombination eine URL kann schnell einige Tausend URLs ergeben.

Empfehlung: Im ersten Schritt muss unterschieden werden ob die Parameter relevant sind.

- relevant: Parameter ändert die Seite maßgeblich → Canonical auf sich selbst

- nicht relevant: Keine Änderungen an der Seite (UTM) → noindex

Generell gibt Markus Hövener die Empfehlung, pro Parameter individuell zu entscheiden und sich vor allem zu fragen, ob es durch die geplante Maßnahme zu anderen Problemen kommen kann wie, dass relevante Seiten nicht mehr erreichbar sind.

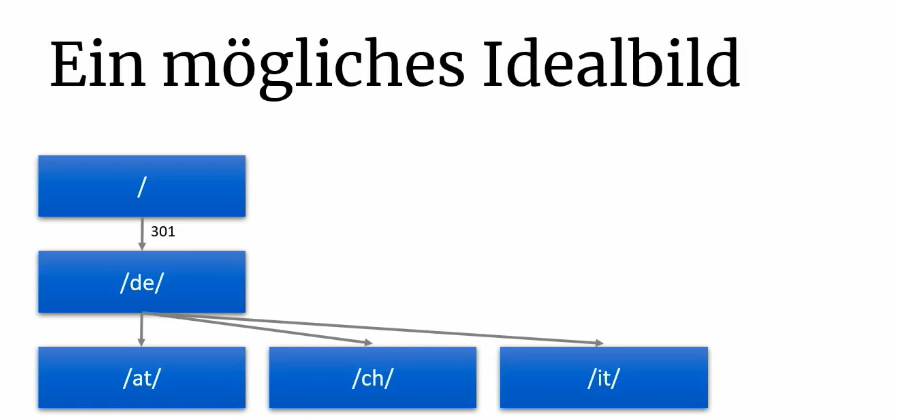

Pattern 5 - International SEO

Internationale Websites und Domains können unterschiedlich angelegt werden: als Verzeichnis /de-de/, als Subdomain oder als ccTLD.

Durch Verzeichnisse mit gleicher Sprache, aber in unterschiedlichen Ländern (en-bl/en-nl) kommt es zu Duplicate-Content. Des Weiteren ist die interne Linkstruktur und Crawl-Tiefe bei der Verwendung von Verzeichnissen zu beachten.

Empfehlung: Folgende Struktur empfiehlt Markus Hövener für eine internationale Website:

GSC WOW - Google-Search-Console richtig nutzen

Nora Taubert

Nora zeigte auf, welche zahlreichen Möglichkeiten die Google-Search-Console bietet. Dabei ging sie durch die einzelnen Funktionen wie die Filterungen (Land, Sprache etc.), mit denen die ermittelten KPIs (Klicks, Impressionen, CTR und Rankings) nach den gewünschten Kriterien anzuzeigen.

In diesem Hands-on-Vortrag wurden die bewährten Vorgehen aufgezeigt und mögliche erweiterte Analysen. So wurde beispielhaft gezeigt, wie sich negativ entwickelnde KPIs ermittelt werden können und näher betrachtet.

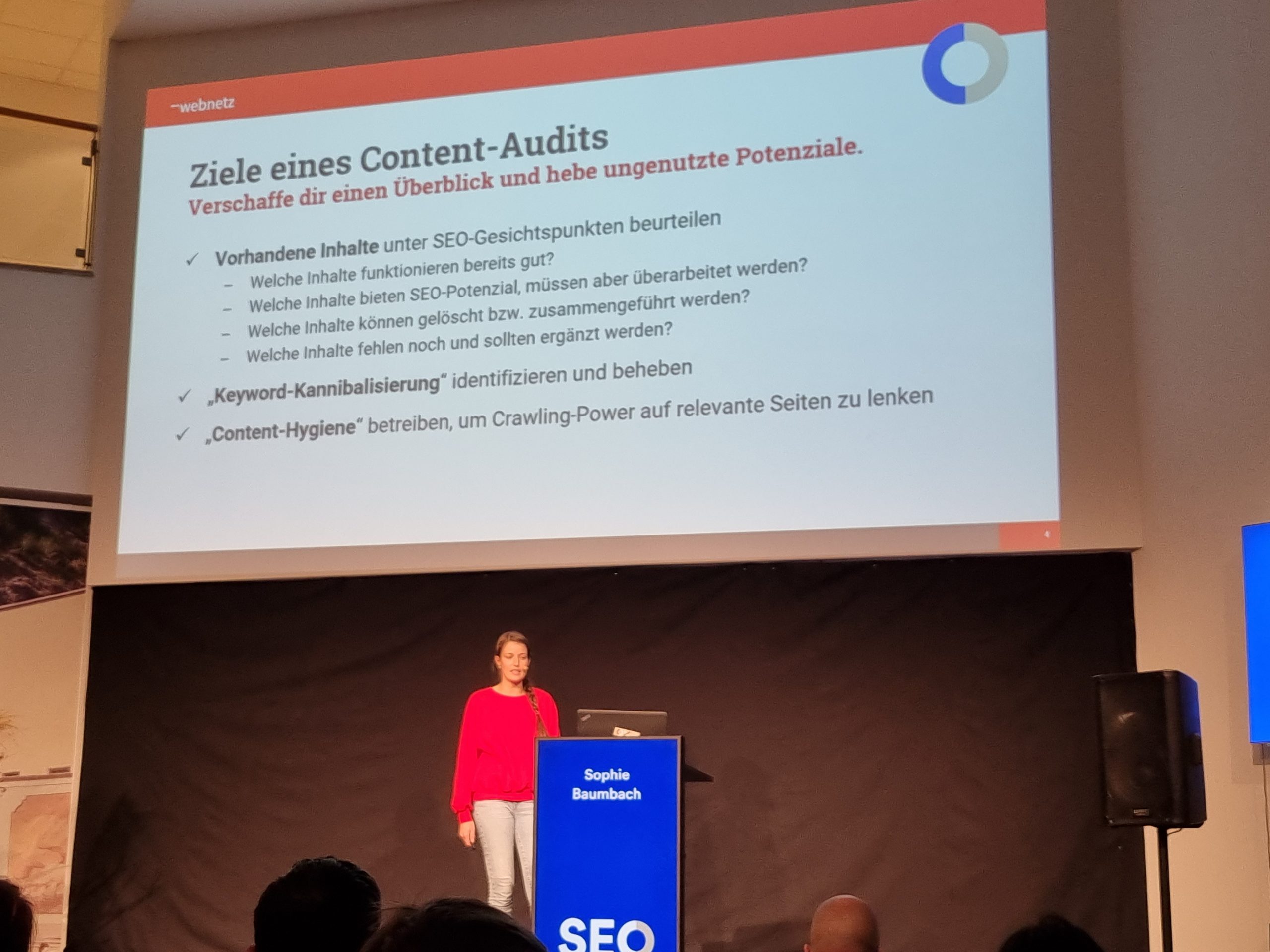

Der erfolgreiche Content-Audit: individuelle Tipps für unterschiedliche Website-Typen

Sophie Baumbach

Der Vortrag von Sophie Baumbach fasste anschaulich zusammen, welche Analysen in einen Content-Audit gehören und welches Vorgehen sie für die Erschließung der Daten empfiehlt.

Als Ziel sieht Sophie die Erlangung eines Überblicks über die bestehenden Inhalte der Website.

Dafür sollen folgende Fragen geklärt werden:

- Welche Inhalte funktionieren bereits gut?

- Welche Inhalte bieten SEO-Potenzial, müssen aber überarbeitet werden?

- Welche Inhalte können gelöscht bzw. zusammengeführt werden?

- Welche Inhalte fehlen noch und sollten ergänzt werden?

Für die Analysen nutzt sie Crawling-Tools wie Screaming-Frog und ergänzt die Rohdaten mit Performance Daten aus Google-Analytics, Google-Search-Console, Sistrix und ahrefs. Alle Daten fügt sie für den Überblick zusammen und baut aus diesen ihre Analysen auf.

Hierbei gibt es kein einheitliches Vorgehen, sondern ein individuelles Eingehen auf die Größe der Domain und die Ziele der Kunden. Während bei kleinen Domains ein manuelles Vorgehen möglich ist, gilt es bei großen Domains Muster zu erkennen und daraus Ableitungen zu treffen.

Auch die Keyword-Strategie gehört für Sophie zu einem Content-Audit dazu. Hierbei werden sowohl der bestehende Keyword-Fokus bewertet wie auch Potenziale erarbeitet. Ziel dahinter ist einerseits, Keyword-Kannibalisierungen zu identifizieren und zu beheben sowie auch Content-Hygiene zu betreiben, um Crawling-Power auf relevante Seiten zu lenken.

Aus den Analysen erstellt Sophie einen Maßnahmenplan, der aus verschiedenen Maßnahmenpaketen besteht, die besser handelbar sind. Dieser enthält Detail-Empfehlungen pro URL, globale Optimierungsmuster und weitere Empfehlungen z.B. aus Wettbewerbscheck. Hierbei wird jeweils eine Aufwandsschätzung gegeben bzw. die benötigten Ressourcen geschätzt, um so auch das Kosten-Nutzen-Verhältnis abzuwägen.

Auf dem Bild zu sehen: Sophie Baumbach

On-SERP-SEO in turbulent times

Izzi Smith

Aus SEO-Sicht war das Jahr 2021 ein stürmisches. Unzählige Google-Updates haben die SERPs immer wieder verändert. Izzi Smith zeigt in ihrem Vortrag, wie sie mit den Turbulenzen umgeht und was getan werden kann, um sich auf zukünftige Herausforderungen vorzubereiten.

Zunächst geht Izzi Smith auf das Monitoring ein – und hier gibt es keinen Platz für Fehler. Ein makelloses Monitoring hilft dabei, Veränderungen frühzeitig zu erkennen und dementsprechend handeln zu können, so z. B. bei Googles Top-10-Tests.

Besonders wichtig für Izzi ist die Kontinuität. Einmal optimiert, darf nicht alles stehen und liegen gelassen werden, denn nach der Optimierung ist vor der Optimierung. Ganz nach dem Motto „Die Konkurrenz schläft nicht“ fordert Izzi dazu auf, kontinuierlich die Präsenz einer Website in den SERPs zu verbessern. Featured Snippets, Rich Results und die People-Also-Ask-Box sind nur einige Möglichkeiten, um sich zusätzlichen Platz und Aufmerksamkeit in den SERPs zu sichern.

Izzi rät außerdem dazu, Videos gezielt zu optimieren. Relevante Videoabschnitte können in den SERPs ausgespielt werden. Um Relevanz für Suchbegriffe zu signalisieren, empfiehlt es sich, mit Text, Untertiteln und Timestamps im Video zu arbeiten und auch die Description gezielt zu optimieren, so z. B. durch das Bereitstellen einer Übersicht, wann in einem Video welches Thema behandelt wird.

Aber ist es nicht so, dass ich bei so viel bereitgestellten Informationen auf den SERPs wesentlich weniger Klicks auf meine Ergebnisse erzielen kann? Diese Annahme ist natürlich nicht falsch. Viele Nutzer:innen sind mit den Informationen auf den SERPs bereits zufrieden. In diesem Szenario steckt jedoch trotzdem Potenzial – vor allem für die Brand-Awareness und den sogenannten Lifetime-Click.

Izzi sieht das Thema wie folgt: Auch wenn Nutzer:innen nicht klicken, ist es wichtig seine Marke ganz oben zu positionieren. Denn es ist im ersten Schritt nicht wichtig, ob Nutzer:innen das bereitgestellte Ergebnis klicken, wichtig ist nur, dass sie den Klick nicht bei der Konkurrenz lassen. Heute hat die Information auf den SERPs vielleicht genügt, aber spätestens, wenn Nutzer:innen detaillierte Antworten auf Fragen brauchen, dann werden sie auf die Marken zurückkommen, die sich bereits in der Vergangenheit als Experten platziert haben.

Im nächsten Schritt empfiehlt Izzi Smith bei weiteren On-SERP-Optimierungen auch mit A/B-Tests zu arbeiten, um herauszufinden, wie die CTR immer weiter verbessert werden kann.

Mit makellosem Monitoring, kontinuierlichen Optimierung und einem starken Fokus auf User-Experience und Intent, kann man sich gezielt auf zukünftige Herausforderungen in der Suchmaschinenoptimierung vorbereiten. Izzi rät abschließend, Googles Ziele und Werte immer im Auge zu behalten – so ist man auch auf unerwartete Änderungen vorbereitet und kommt an einen Punkt, an dem Google einen nicht mehr überraschen kann.

Auf dem Bild zu sehen: Izzi Smith

High Quality vs. Fuck-up: Was unterscheidet ein gutes von einem schlechten SEO-Audit?

Mandy Fröhlke

Mandy Fröhlke stieg in ihren Vortrag mit ein paar Customer-Insights ein. Daran zeigte sie die Gründe für einen Audit auf und welche Ergebnisse sie bei den Kunden erzielt hatte.

Case 1

Bei einem B2B-Kunden waren die meisten Inhalte in Download-Content wie z. B. PDFs enthalten. Nach der Migration der Inhalte und technischer Optimierung steigen vor allem die Sichtbarkeit, der Traffic und folglich auch die Leads

Case 2

In einem anderen Projekt waren die Indexierungsanweisungen wohl willkürlich angelegt. Nach der Umsetzung der empfohlenen Maßnahmen haben sich einfach alle KPIs verbessert.

Case 3

Wieder ein B2B-Unternehmen. Bei diesem internationalen Projekt war ein extremer Sprach-Mix auf allen Seiten vorhanden, es gab keine Einstiegsseiten für die Branchen und über 60 Prozent der Seiten brachten keinen Traffic. Das Ergebnis nach einer gezielten Reduktion der Sprachversionen war, dass weniger Content-Budget für Erstellung der weiteren Inhalte benötigt und Duplicate-Content massiv beseitigt wurde.

Welchen Mehrwert soll ein guter SEO-Audit bieten?

- Stärken und Schwächen einer Seite aufzeigen

- Potenziale aufdecken

- die Ressourcennutzung verbessern

- Kosten sparen

Welche Ziele werden durch einen Audit verfolgt?

Für Kunden:

- Identifikation von Traffic-Verlusten

- eigene Potenziale von Wettbewerbern ableiten

- Sales/Leads erhöhen

- Content-Gaps identifizieren

Für Agenturen:

- Webseite verstehen

- Gewichtung von SEO-Maßnahmen festlegen

- Vorbereitung für einen Relaunch

Vier Säulen der SEO-Optimierung

Nach diesen Grundbedingungen erklärte Mandy, dass ein guter Audit auf den vier Säulen der Suchmaschinenoptimierung basieren muss. Sprich: Onpage SEO, Offpage SEO, Content und UX führen zu einer SEO-Strategie.

Auch für Agenturen waren gute Tipps dabei. Bevor man sich auf routinierte Analysen stürzt, ist es wichtig, dass die Seiten manuell untersucht werden und sich die Dienstleister in die Lage der Kunden versetzen. In einem Audit müssen die Kunden im Fokus stehen und es sollten auch positive Ergebnisse mitgeteilt werden. Eine vollständige Übersicht eignet sich natürlich für Folgeaudits. Das Vier-Augen-Prinzip sorgt für eine gute Qualität.

Potenzielle Fuck-ups

Zuletzt wurden noch kurz potenzielle Fuck-ups erläutert:

- falsche Zielvorstellungen

- unsaubere Timings

- Verantwortlichkeiten werden nicht geklärt

- keine Priorisierung der Maßnahmen

- nur ein Crawl während des Projekts

- 08/15-Screenshots

- unbekannte Zielgruppe

- Buzzword-Bingo

- kein Tracking

Yes, WE LOCAL! Sie Story hinter SportSchecks 600-Prozent-Local-SEO-Boost

Nico Erpel

In seinem Vortrag „YES, WE LOCAL! Die Story hinter SportSchecks 600% Local SEO Boost” stellte Nico Erpel die Bedeutsamkeit von Local SEO für standortgebundene Kunden vor.

Zu Beginn nahm Erpel das Auditorium mit auf einen Exkurs, in dessen Verlauf er die Herausforderungen und Lösungsansätze für lokale Suchanfragen darlegte.

Stagnierende organische Sichtbarkeit bei den Standort-Einträgen, hoher Konkurrenzdruck bei generischen Begriffen und die Vermeidung von Duplicate-Content seien seiner Aussage nach die maßgeblichen Herausforderungen bei der Optimierung des Kunden „SportScheck“ gewesen.

Die Lösung lag in einer umfassenden Local-SEO-Strategie, die neben einer Keyword-Strategie die Content-Optimierung und individuelle Inhalte für die ideale Nutzeransprache beinhaltete, aber auch aktualisierte und optimierte Google-My-Business und Filialwebsiten und schließlich auch den ständigen Austausch mit sämtlichen für den Prozess relevanten Stakeholdern einschloss.

Nico Erpel hat seinen Zuhörer:innen erfolgreich aufgezeigt, dass in Local SEO viel Potenzial stecken kann und dass jedes Unternehmen, das sich standortabhängig erfolgreich im Netz platzieren möchte, nicht an einer Local-SEO-Strategie vorbeikommt.

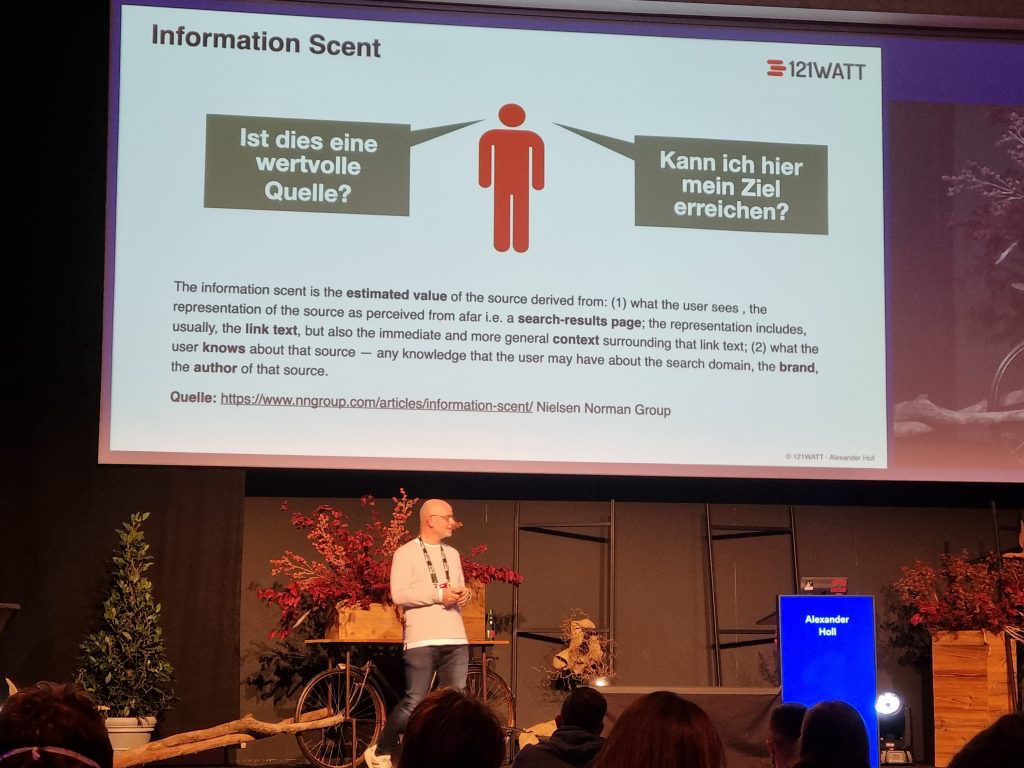

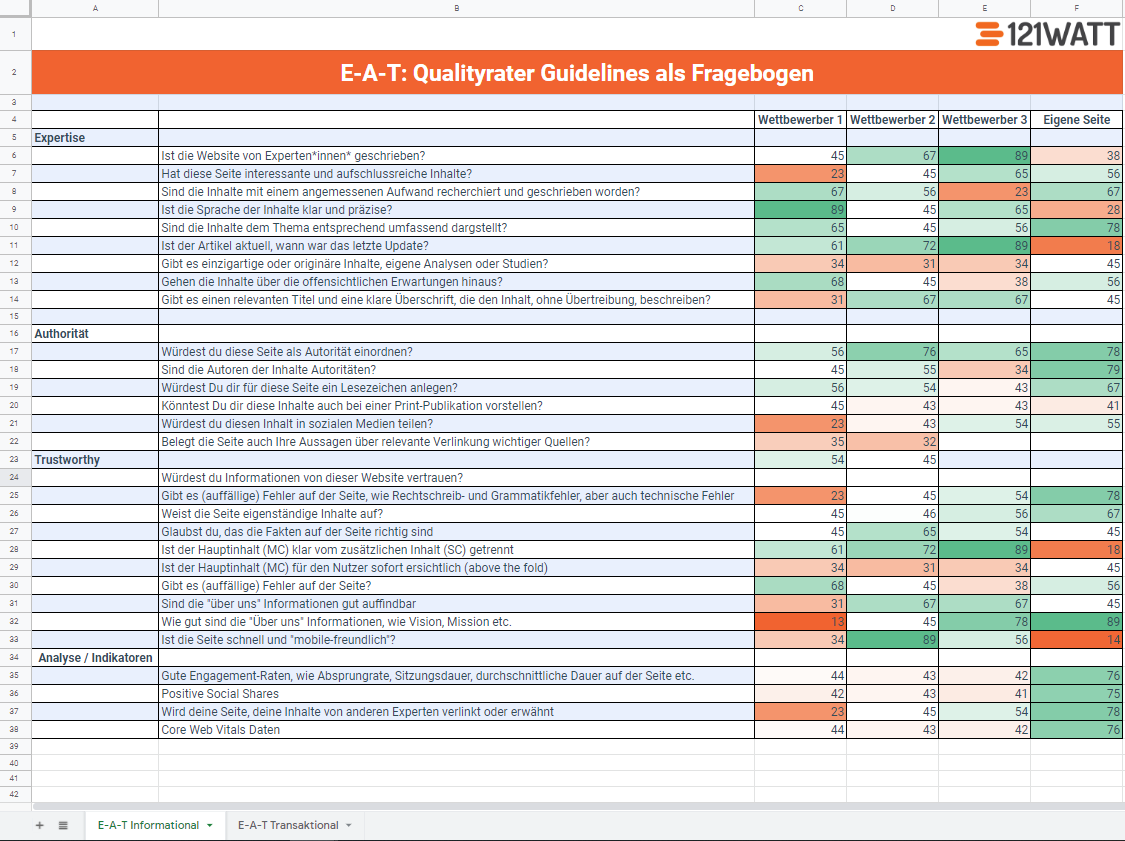

E-A-T, SEO zwischen Relevanz und Qualität

Alexander Holl

Das Thema E-A-T ist seit einigen Jahren in aller Munde. Doch was bedeutet es eigentlich genau und wie optimiert man auf E-A-T? Dies zeigt Alexander Holl von 121Watt anschaulich und fundiert in seinem Vortrag bei der SEOkomm.

Das Akronym E-A-T steht für Expertise, Authority und Trustworthiness. Diese drei Faktoren spielen eine zentrale Rolle in der Bewertung von Seiteninhalten.

Nutzer:innen haben ein Bedürfnis: Sie suchen nach der Lösung. Ab diesem Punkt muss der:die Nutzer:in die Quellen hinsichtlich ihrer Expertise, Autorität und Glaubwürdigkeit einstufen. Zwei zentrale Fragen treten hier in den Raum:

- Ist dies eine wertvolle Quelle?

- Kann ich hier mein Ziel erreichen?

Suchmaschinen müssen dabei sicherstellen, dass Nutzer:innen qualitative hochwertige Inhalte bekommen. Deswegen verankern sie in ihren Algorithmen Prüfkriterien.

Da die Algorithmen von Suchmaschinen sehr komplex und abstrakt und somit nicht einfach verständlich sind, hilft es die Richtlinien für Webmaster mit den “Search Quality Evaluator Guidelines” zu lesen und aus ihnen Rückschlüsse auf die Blackbox Google zu ziehen. Das hat Alexander gemacht und daraus einen Fragebogen entwickelt. Dieser bietet die Möglichkeit, Wettbewerber anhand von verschiedenen Fragen zu den Bereichen Expertise, Authority und Trustworthy zu vergleichen.

Mit Fragen wie “Ist die Website von Experten geschrieben?”

“Sind die Inhalte mit einem angemessenen Aufwand recherchiert und geschrieben worden?”

“Würdest du diese Seite als Autorität einordnen?” oder

“Würdest du Informationen von dieser Website vertrauen?” lassen sich Analysen sinnvoll und effizient durchführen und Maßnahmen ableiten.

Vielen Dank für die Bereitstellung dieses super hilfreichen Fragebogens Alexander!

Eine Maßnahme könnte hierbei eine Autorenbox sein, welche für User:innen die Möglichkeit bietet, mehr Informationen über den:die Autor:in hinsichtlich der Expertise, Glaubwürdigkeit und Autorität zu erfahren. Hier bieten sich insbesondere spezifische Landingpages mit weiteren Informationen zu den Autor:innen an. Eine weitere Maßnahme können strukturierte Daten für Artikel mit Angabe von “author” sein. Aufgelockert wurde der Vortrag von Alexander durch die Analyse bekannter SEOs und ihrer Autorenprofile. Sagen wir es mal so: Da haben fast alle noch etwas Handlungsspielraum. 😉 Das war auf jeden Fall ein sehr gelungener Vortrag, aus dem wir viel mitnehmen konnten!

Relaunch as it was: Learnings & Herausforderungen der hartlauer.at

Lidwina Hirsch, Vanja Venek

In ihrem Vortrag gaben Lidwina Hirsch und Vanja Venek Einblicke in den Relaunch von hartlauer.at. Venek und Hirsch ließen die Zuhörer:innen daran teilhaben, wie sie in nur einem Jahr einen Omnichannel-Relaunch durchführten und was sie während dieser Zeit erlebt haben.

Hirsch legte dar, dass es für sie als Vertreterin der Kundenseite einige Herausforderungen zu bewältigen gab. Zum einen musste sie erst einmal intern ein Bewusstsein für die Notwendigkeit von SEO etablieren und im nächsten Schritt die sehr große Anzahl von unterschiedlichen Stakeholdern in das Projekt zu integrieren. Die Vielzahl Stakeholder machte die Umsetzung von Prozessen und die Behebung von Fehlern sehr zeitaufwändig.

Auf Agenturseite lagen für Venek die größten Herausforderungen in der Anpassung und Optimierung der Metadaten, der Indexierung, der Seitenstruktur und vor allem der Redirects. Agenturseitig war es wichtig, kritische Punkte klar zu definieren, früh zu erkennen und transparent das Risiko abzuschätzen und dem Kunden transparent und proaktiv zu kommunizieren.

Offen erzählten die beiden Rednerinnen über die Fortschritte der Zusammenarbeit, aber auch über Rückschläge und Krisen, die bei ihrem Projekt aufkamen. Ein erfrischender Vortrag, der zeigt, wie wichtig transparente und offene Kommunikation für ein erfolgreiches Projekt sind.

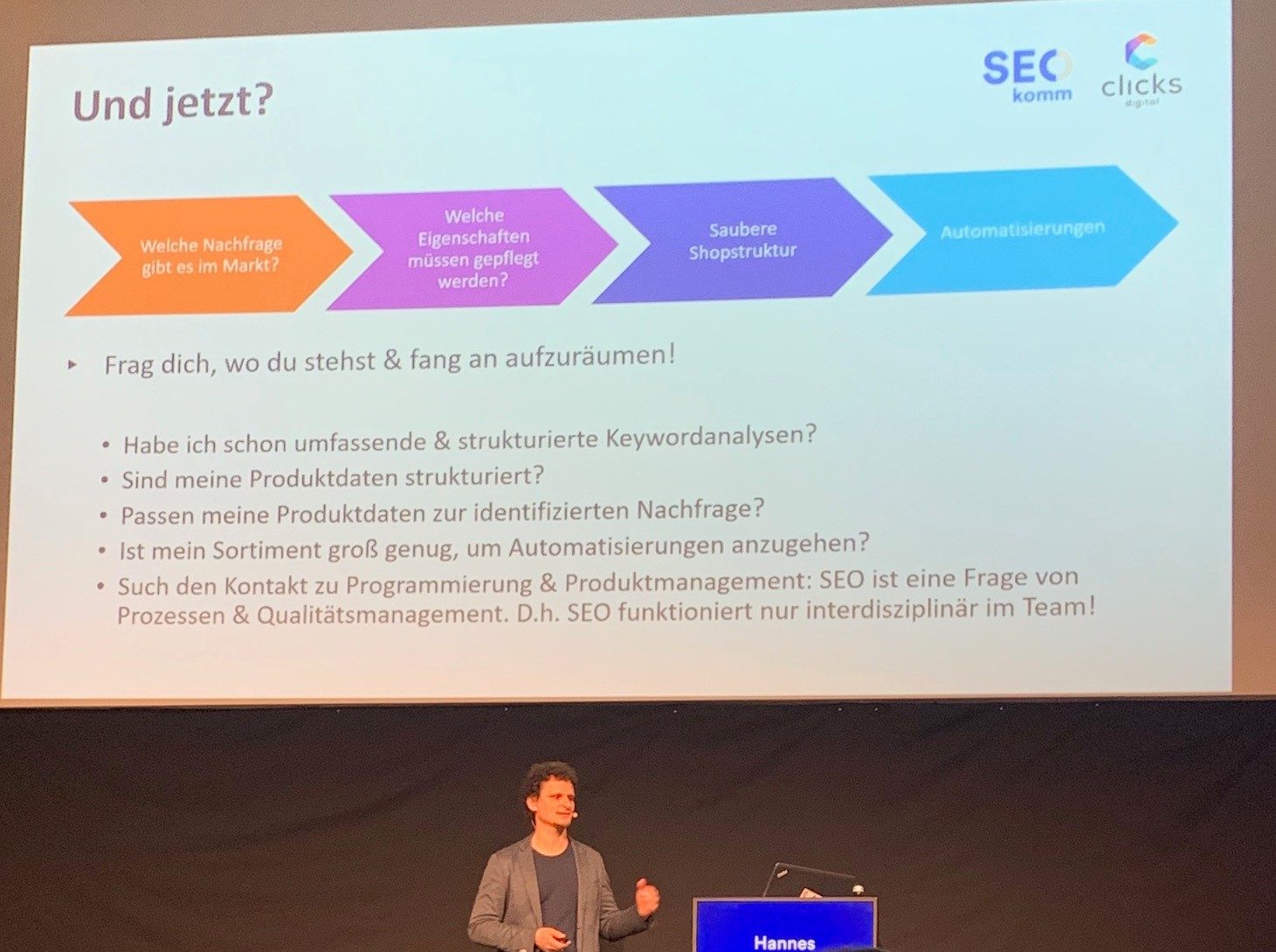

SEO beginnt im Datenmanagement

Hannes Richter

Hannes Richter schildert uns zu Beginn seines Vortrags ein persönliches Dilemma: Bereit zum Kauf eines Mountainbikes, sucht er bei Google nach einem spezifischen Longtail-Keyword, von dem er sich das perfekte Suchergebnis verspricht. Doch ein zu 100 Prozent passendes Ergebnis bleibt aus.

Das Problem: die Erwartungskonformität. Nutzer:innen, die in der Customer-Journey bereits kurz vor dem Kauf stehen, suchen sehr detailliert und erwarten ein genau passendes Ergebnis. Kann dieses Ergebnis geliefert werden, ist eine Conversion sehr wahrscheinlich. Ist das Suchergebnis in einem oder mehreren Details allerdings unpassend, kann die Erwartung der Nutzer:innen nicht erfüllt werden und der erhoffte Klick bleibt aus.

Das Prinzip scheint einfach, doch an verschiedenen Beispielen zeigt Hannes Richter, dass es hier auch in vermeintlich wettbewerbsintensiven Bereichen noch viel Potenzial gibt. Auch wenn das Suchvolumen der Longtail-Anfragen oft gering ist, lohnt es sich in vielen Fällen, eine genau passende Landingpage bereitzustellen, um die gewünschte Conversion für sich zu gewinnen.

Viele Shops führen tausende von Produkten in unterschiedlichen Farben, Formen und Ausfertigungen. Wie kann hier also für jedes Produkt in unterschiedlichen Ausprägungen eine passende Landingpage bereitgestellt werden?

Die Produktdaten können hier als Grundlage zur Skalierung verwendet werden. Sind diese Daten korrekt und ordentlich gepflegt, können sie zur automatisierten Erstellung von genau jenen passenden Landingpages genutzt werden, die komplizierte Longtail-Suchanfragen abdecken.

Um hierbei jedoch erfolgreich zu sein, muss das Datenmanagement sitzen. Die Produktdaten müssen unter Beachtung der folgenden Punkte optimiert werden:

1. Nachfrage am Markt

Attributgetriebene Keyword-Recherchen helfen dabei, verschiedene Keyword-Kombinationen zu identifizieren. Es muss analysiert werden, was wirklich hinter einem Keyword steckt, z. B. Marke, Produktname, Produkttyp, etc. Abstrahieren und Zerlegen sind hier die Stichwörter.

2. Relevante Produkteigenschaften

Unter enger Zusammenarbeit mit den Produktmanagern müssen bestehende Produkteigenschaften geprüft und ggf. neue Produkteigenschaften hinzugefügt werden. Es muss auf Stringenz geachtet werden.

3. Saubere Shopstruktur

Diese muss je nach Unternehmensstrategie individuell angepasst werden. Ziel ist es, für alle wichtigen Suchanfragen die relevanteste Inhaltsseite zu bieten. Es muss hier z. B. geklärt werden welche Produkteigenschaften führen und welche untergeordnet werden.

4. Automatisierungen

Produktdaten können nur sinnvoll für die Skalierung genutzt werden, wenn sie sauber gepflegt sind. Ist dies der Fall bieten sich Automatisierungen für viele Punkte an, so z. B. für die Landingpage- inklusive Texterstellung und die interne Verlinkung von weiteren passenden Kategorien.

Zusammenfassend lässt sich sagen, dass hinter der Optimierung von Produktdaten laut Hannes Richter viele SEO-Potenziale stecken.

Auf dem Bild zu sehen: Hannes Richter

So hast du das noch nie gesehen: Interne Verlinkungsanalyse like a Pro

Johan von Hülsen

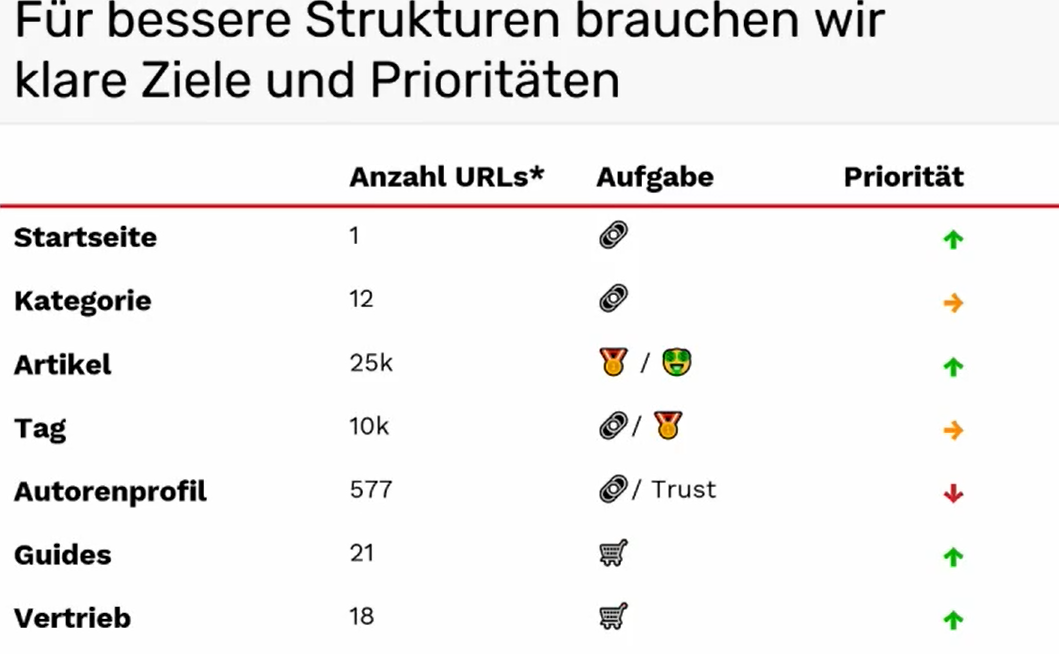

Johan von Hülsen zeigte in seinem 35-minütigen Vortrag, wie die interne Verlinkung einer Seite analysiert, bewertet und anschließend optimiert werden kann. Als Beispiel verwendet er die Website des bekannten Digital-Business-Magazins T3N.

Bevor es in die Analyse und Optimierung der eigenen Linkstruktur geht, rät der Speaker, die Seitentypen zu unterteilen, mit Zielen zu hinterlegen und entsprechend für die Verlinkung zu priorisieren.

Anschließend gilt es, Daten zu sammeln. Hierzu wird als Hauptwerkzeug Screaming-Frog genannt, mittels dessen Metriken ermittelt werden wie:

- Links auf Fehlerseiten

- Orphaned-Pages

- Anzahl der Links pro Seitentyp und PageRank pro Bereich

Auswertung in der Praxis

Neben dem klassischen SEO-Tool hat Johan von Hülsen ein eigens entwickeltes Skript als Geschenk dabei, welches bei der Analyse behilflich ist.

Der Hauptteil der Präsentation bestand aus der anschließenden Auswertung der gesammelten Daten und der Bewertung der aktuellen Verlinkung. Ausführlich wird gezeigt, wie die verschiedenen Metriken interpretiert und genutzt werden. Zwischen den einzelnen Folien gießt Johan immer wieder Fakten bzw. Aussagen von Google hinsichtlich der internen Verlinkung ein.

Ergebnis nach der Auswertung: Im Beispiel von T3N sind vor allem die Tag-Seiten hinsichtlich der internen Verlinkung sehr stark sind, welche aber eher niedriger priorisiert wurden. Die Startseite gehört dagegen eher zu den schwächeren Seiten.

Den Abschluss des Vortrags bildeten die Empfehlungen, wie die interne Verlinkung nun anhand der gewonnenen Erkenntnisse optimiert werden kann.

Fazit:

- Interne Verlinkung gehört zu den größten Hebeln

- Interne Verlinkung muss operationalisiert werden

- Links müssen Sinn ergeben

Zuletzt gab es noch ein paar Quick-Tipps. Besonders erwähnenswert sind hier die Rechtschreibprüfung, welche schon für viele Sprachen verfügbar ist und dass man sich in der Übersicht mittels Rechtsklick den Crawl-Path einer Seite anzeigen lassen kann, um nachvollziehen zu können, über welchen Pfad eine URL am schnellsten erreichbar ist.

Learnings von 1.592 Start-ups: Strategien für SEO und Content-Marketing

Viola Eva

Mit ihrer Agentur flow SEO spezialisiert sich Viola Eva vor allem darauf, Software und E-Learning-Start-ups im Bereich Suchmaschinenoptimierung zu unterstützen. Über die Jahre hat sie mit zahlreichen Startups erfolgreich zusammengearbeitet und konnte nun über gezielte Datenauswertungen einige Erkenntnisse über die jungen Unternehmen gewinnen.

Die erfolgreichsten der betrachteten Start-ups, jene, die inzwischen mehr als eine Million Klicks pro Monat generieren, haben alle eines gemeinsam: Programmatic SEO.

Nur sechs der 1.592 betrachteten Start-ups konnten es mit Programmatic SEO so weit bringen. SEO ist bei ihnen Teil der Produkt-Strategie. Durch Automatisierungen, Templates und entsprechende Keyword-Konzepte können tausende von relevanten Seiten in den Index gebracht werden, ohne immense Mehraufwände in der Contenterstellung und -pflege zu verursachen. Denn klar ist „wenn du nicht darüber geschrieben hast, kann Google dich auch nicht dafür ranken“ und Backlinks alleine reichen heutzutage nicht mehr aus.

Was rät Viola Eva jungen Start-ups in der Szene also, wenn es um SEO und Content-Marketing geht?

Sobald das finale Produkt fertig ausgearbeitet ist und keine maßgeblichen Veränderungen mehr daran vorgenommen werden, sollte mit den ersten SEO-Maßnahmen gestartet werden. Man spricht hier vom sogenannten Product-Market-Fit. Ist dieser erreicht, kann die Optimierung von Inhalten für die definierte Zielgruppe gestartet werden. Vorweg können bereits PR- bzw. Funding-Runden für die Generierung von Backlinks und Authority genutzt werden.

Des Weiteren empfiehlt Viola Eva Content für den gesamten Funnel zu erstellen. Für Start-ups lohnt es sich ihrer Aussage nach, von unten nach oben zu arbeiten. Das heißt, dass zunächst Texte für Conversion-getriebene Seiten wie z. B. Produktseiten erstellt werden, bevor man sich den Conversion-vorbereitenden Seiten, wie z. B. Blogbeiträgen, widmet.

Allgemein hat Viola einen wunderbaren Einblick in ihre tägliche Arbeit mit Software und E-Learning Start-ups gegeben und die SEOkomm-Besucher:innen mit interessanten Fakten abgeholt.

Auf dem Bild zu sehen: Viola Eva

Fazit zur SEOkomm 2021

Trotz der besonderen Umstände war die SEOkomm eine absolut gelungene Konferenz. Großer Dank geht hier an Oliver und Uschi Hauser und das gesamte Team, die wieder einmal erreicht haben, dass wir uns sehr willkommen geheißen fühlten. Der einzige Wermutstropfen war die ausgefallene Abendveranstaltung, was aber in Anbetracht der gegebenen Umstände mehr als verständlich war. Wir freuen uns schon sehr auf die SEOkomm 2022!