Viele URLs im Index von Suchmaschinen zu haben, scheint auf den ersten Blick sinnvoll zu sein. Je mehr URLs im Index sind, desto mehr URLs können auch gefunden werden. Diese Betrachtungsweise ist nur äußerst bedingt korrekt. Das Ziel einer gesteuerten Indexierung ist es, nicht unnötig viele URLs von Suchmaschinen indexieren zu lassen. Es sollen nur URLs in den Index aufgenommen werden, die einzigartig sind und einen Mehrwert für die Seite darstellen.

Suchmaschinen versuchen immer für eine konkrete Suchanfrage ein möglichst passendes Ergebnis zu liefern. Sind auf einer Domain identische Inhalte unter verschiedenen URLs zu erreichen, ist es für Suchmaschinen schwierig, die relevantere URL herauszufinden und diese auch in den SERPs anzuzeigen. Mehrere verschiedene URLs mit identischen oder nahezu identischen Inhalten können sich so gegenseitig kannibalisieren.

Doppelt problematisch ist die Indexierung von URLs, die nur einen sehr geringen oder keinen Inhalt aufweisen (Thin Content). Die URLs bieten keinen Mehrwert für eine Domain und können dadurch nur sehr schlecht ranken. Das angestrebte Ziel sollte es sein, nur Ranking-relevante URLs im Index zu haben.

„Das angestrebte Ziel sollte es sein, nur Ranking-relevante URLs im Index zu haben. „

Weiterer Nachteil einer unkontrollierten Indexierung ist eine Begrenzung des Crawl-Budgets von Google für eine Seite. Google vergibt für jede Webseite ein gewisses Crawl-Budget. Dieses Crawl-Budget definiert sich nicht durch eine festgelegte Anzahl an Seiten, sondern mehr durch einen festgelegten Zeit-Slot für den Googlebot. Der Bot folgt immer allen vorhandenen Links einer Webseite und versucht in der vorgegebenen Zeit, möglichst viele URLs zu crawlen und gegebenenfalls in den Index aufzunehmen.

Hat eine Seite sehr viele URLs ohne Mehrwert, die erreicht und indexiert werden, hält der Bot sich unnötig mit irrelevanten Seiten auf. Das Crawl-Budget könnte sinnvoller genutzt werden, um relevante Seiten zu erreichen und deren Inhalt in das Ranking mit einzubeziehen. Relevanter Content erzielt so nicht die Aktualität und Aufmerksamkeit, die notwendig wäre.

Bei anderen erfolgreichen Suchmaschinen wird das Crawl-Budget ähnlich festgelegt.

Eine große Anzahl an Links kann oftmals durch Paginierungen, Archive, Tag-Seiten, Parameter und Filter erzeugt werden. Durch die extreme Anzahl an URLs ist es dem Crawler zusätzlich zu den o.g. Duplicate-Content Problemen nicht möglich, die relevanten URLs zu filtern. Ein Großteil der zugewiesenen Crawl-Budget-Zeit verpufft dadurch ungenutzt. Um die Ressourcen optimal zu nutzen, ist eine effiziente Indexsteuerung notwendig.

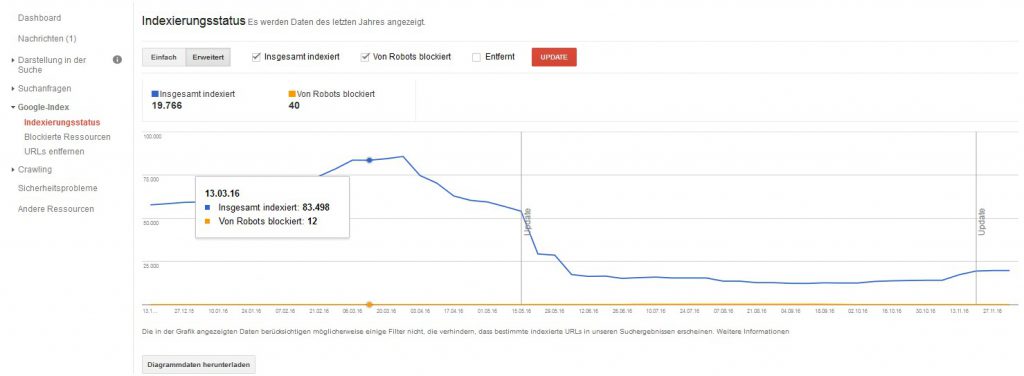

Über die Google Search Console lässt sich der aktuelle Indexierungsstatus jederzeit überprüfen. In dem Bericht „Indexierungsstatus“ werden URLs aufgeführt, die nicht als Duplikate oder als kanonisches Dokument betrachtet werden. Die Daten stimmen in der Regel nicht mit der Site-Abfrage bei Google überein. Google wendet oft Filter an, die beeinflussen können, welche Ergebnisse in der Suche angezeigt werden und welche nicht.

Weitere Infos dazu: https://support.google.com/webmasters/answer/2642366?hl=de

Um den Indexierungsstatus eines Dokuments zu überprüfen, kann die Abfrage über Google mit dem Site:- oder Info:- Operator bei Google verwendet werden. Dazu ist lediglich der entsprechende Operator vor die URL zu schreiben und die Google-Abfrage zu starten.

Site:example.com Info:example.com

Im Folgenden sollen 5 Eingriffsmöglichkeiten in die Indexierung aufgezeigt und deren Tauglichkeit für eine gezielte Steuerung geprüft werden.

- Noindex-/Index-Tag

- Canonical Tag

- Robots.txt

- Linkmaskierung

- Steuerung über die Search Console

Indexsteuerung mittels des Robots-Tag <noindex>

Mittels des Robots-Tags <noindex> können Google und andere Suchmaschinen angewiesen werden, eine Seite nicht in ihren Index aufzunehmen. Eine Seite die bereits indexiert ist, wird durch das Hinzufügen des Tags beim nächsten Crawl entfernt. Die Suchmaschinen folgen dieser Anweisung in der Regel sofort beim darauffolgenden Crawlen der URL.

Die Auszeichnung erfolgt über den folgenden Code im <head>-Bereich einer Seite:

<meta name="robots" content="noindex, follow" />

Das Deindexieren mittels des Noindex-Tags funktioniert bei korrekter Anwendung in der Regel zuverlässig. Um das Tag auslesen zu können, ist es notwendig, dass ein Bot jede URL vorab crawlen muss. Bei einer Vielzahl von möglichen URLs, die beispielsweise durch Filter erzeugt werden, entsteht eine signifikante Verschwendung von Crawl-Budget-Ressourcen für die gesamte Seite. Der Crawler besucht trotz des Noindex-Tags alle URLs, die er erreichen kann bei jedem Crawl-Vorgang (innerhalb des Budget-Limits).

Eine alleinige Verwendung der Indexsteuerung über das Noindex-Tag sollte immer dann eingesetzt werden, wenn gewünscht ist, dass eine Seite bei jedem Besuch gecrawlt wird, um beispielsweise den internen Linkpower-Fluss zu verlinkten Seiten weiterzuleiten oder aufrecht zu erhalten. Mögliche Beispiele sind die Verlinkung von Archivseiten eines Blogs oder Paginierungsseiten ab Seite 2.

Indexsteuerung über das Canonical-Tag

Robots.txt im HTML-Header

Das Canonical Tag wurde von Google 2009 eingeführt um die, in Online-Shops häufig auftretende, Problematik des Duplicate-Contents zu lösen. Der wichtige Unterschied zu den anderen Maßnahmen besteht darin, dass das Canonical Tag lediglich ein Hinweis für die Suchmaschinen ist. Im Gegensatz dazu stehen Anweisungen, an die sich die Crawler regelmäßig halten, wie beispielsweise das Noindex-Tag.

Oft sind identische Seiten unter verschiedenen URLs zu erreichen. Ein Umstand, durch den Google Probleme hatte, eine relevante URL zu definieren, die in den Suchergebnissen angezeigt werden sollte. URLs mit identischem und sehr ähnlichem Inhalt schränken so gegenseitig das Ranking beider Seiten ein. Das Canonical Tag ist ein Hinweis im Head-Bereich eines Dokuments, auf die Original-Ressource des Dokuments. So soll der Hinweis gegeben werden, welche URL die „Alpha-URL“ ist. Sprich, welche URL für das Ranking verwendet werden sollte. Erhaltene interne und externe Linkpower einer URL soll über das Canonical-Tag im Stil einer Weiterleitung weitergegeben werden.

Weitere Informationen zum Thema Weiterleitungen sind hier zu finden:

Das Canonical-Tag ist immer nur als Behelfslösung anzusehen, sollte eine technisch sauberere Lösung nicht möglich sein. Auch von Google war das Tag bei Einführung nur als eine Möglichkeit der Problembeseitigung gedacht. Bei der Programmierung einer Seite sollte generell darauf geachtet werden, dass die Verwendung des Canonical-Tags nicht notwendig ist.

[su_quote url=“#“] Bei der Programmierung einer Seite sollte generell darauf geachtet werden, dass die Verwendung des Canonical-Tags nicht notwendig ist. [/su_quote]

Möglichkeiten, bei denen die Verwendung eines Canonicals eine sinnvolle Verwendung darstellen können, sind beispielsweise der Einsatz von Tracking-Parametern oder Parametern oder verschiedene Darstellungsformen einer URL mit demselben Inhalt. Beispielsweise Produkte in Listen- oder Gridform oder auch Verweise zu einer mobilen Variante.

Seiten, die über das Noindex-Tag bereits von der Indexierung ausgeschlossen sind, aber beispielsweise einen externen Link erhalten, dessen Power abgefangen und weitergegeben werden soll, können über ein Canonical Tag abgefangen werden. Nach Informationen von Google selbst ist die Verwendung von Noindex und Canonical Tag nicht erwünscht. Zumindest in Deutschland wird diese Vorgehensweise aktuell dennoch erfolgreich in der Praxis verwendet.

Zum Nachlesen das Statement dazu von John Mueller: https://www.seroundtable.com/noindex-canonical-google-18274.html

Canonical Tags sind nicht für die Auszeichnung von Paginierungen zu verwenden. D.h. eine Canonisierung der Seite www.beispiel.de/blog/page-2.html auf die Hauptseite www.beispiel.de/blog/ ist nicht korrekt, es handelt sich nicht um ähnliche Seiten. Paginierungsseiten sind von der Indexierung über das Noindex-Tag auszuschließen. Die analoge Vorgehensweise gilt ebenso für Paginierungsseiten von Produktlisten in Online-Shops.

X-Robots-Tag im HTTP-Header

Alle Anweisungen die im Robots-Meta-Tag des HTML-Headers angegeben werden, können auch als X-Robots-Tag als HTTP-Header Antwort gegeben werden.

Bei einer ausschließlichen Verwendung von HTML-Meta-Tags, können Schwierigkeiten auftreten, beispielsweise beim Einsatz eines Proxy-Caches. Werden Daten über Proxy-Server gecacht, werden in der Regel nur die Daten des HTTP-Headers ausgelesen, da die HTML-Daten von Proxy-Servern üblicherweise nicht ausgelesen werden.

Die Anweisungen im HTTP-Header dominieren die Meta-Angaben des HTML-Headers. In der Praxis ist es oft üblich, ausschließlich auf die Meta-Angaben zurückzugreifen, da die Eingabemöglichkeiten dort wesentlich einfacher sind und in der Regel über das Backend eines CMS erfolgen können. Browser verwenden normalerweise die Daten des HTML-Headers, sofern im HTTP-Header nichts hinterlegt ist.

Für Dateien, die keinen HTML-Header besitzen, ist es notwendig, eine Noindex-Anweisung im HTTP-Header zu integrieren. Oft wird beispielsweise durch eine PDF-Datei möglicherweise Duplicate Content erzeugt. Da hier keine HTML-Meta-Daten angegeben werden können, ist nur die Verwendung des HTTP-Headers möglich.

Weitere Informationen zum Robots-Tag für Webmaster gibt es direkt bei Google: https://developers.google.com/webmasters/control-crawl-index/docs/robots_meta_tag

Indexsteuerung über die Robots.txt

Um das oben beschriebene Problem des verschwendeten Crawl-Budgets zu unterbinden, ist rein technisch gesehen die Robots.txt eine schnelle und einfache Möglichkeit, um effektiv eingreifen zu können. Ein Ausschluss der Crawler über die Robots.txt stellt eine Möglichkeit dar, mit der URLs vom Bot nicht gecrawlt werden. Zugeteiltes Crawl-Budget kann so eingespart werden. Alle Crawler folgen in der Regel den Anweisungen aus der Robots.txt. Allerdings hat auch jeder Crawler die Möglichkeit, die Robots.txt zu ignorieren und auf vermeintlich gesperrte Verzeichnisse zuzugreifen.

Die Verwendung der Robots.txt ist für die reine Indexsteuerung nur äußerst bedingt einsetzbar. Eine Ausspielung auf URL-Basis ist sehr fehleranfällig und der Umstand, dass oft durch fehlerhafte und komplexe Robots.txt Dateien, wichtige Daten für Suchmaschinen gesperrt werden, birgt ein großes Risiko bei der unbedarften Verwendung. Google hat beispielsweise die Möglichkeit, einzelne Seiten zu rendern und die gerenderte Version für das Ranking zu bewerten.

„Die Verwendung der Robots.txt ist für die reine Indexsteuerung nur äußerst bedingt einsetzbar. „

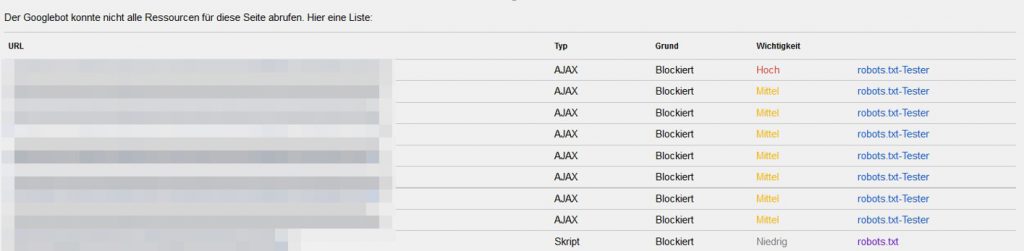

Werden nun für das Rendering benötigte Ressourcen durch die Robots.txt gesperrt, fehlt Google die Möglichkeit die Seite korrekt darzustellen, sodass sie möglicherweise die für die User sichtbaren Inhalte anders und falsch bewertet. Diese Situation ist in jedem Fall nachteilig für das Ranking der URL.

Typische gesperrte Ressourcen sind Javascript-Dateien, Bilderverzeichnisse, AJAX-Inhalte oder CSS Dateien. Google gibt über die Search Console aus, welche Daten zum erfolgreichen Rendern oder Laden einer URL blockiert werden oder nicht erreichbar sind.

Bei einer korrekten Verwendung der Robots.txt muss allen Suchmaschinen-Crawlern die Möglichkeit geboten sein, auf alle benötigten Inhalte einer Seite zuzugreifen und diese auch darstellen zu können. Mögliche Einsatzgebiete können Admin-Bereiche oder Bereiche persönlicher interner Daten sein. Diese sollten bei korrekter Umsetzung nicht verlinkt und an keiner Stelle für die Darstellung der Seite benötigt werden. Ohne spezielle Anforderungen der Webseite sollte die Robots.txt Zugriff auf alle Bereiche der Webseite gewähren.

Ferner existiert auch die Möglichkeit über die Robots.txt bestimmte URLs oder Bereiche von der Indexierung auszuschließen. Aufgebaut ist die Anweisung analog zur „Disallow“ Anwendung. Der Unterschied besteht darin, dass die Inhalte nicht für Crawler blockiert werden, sondern lediglich von der Indexierung ausgeschlossen werden. Die Methode sollte in der Praxis jedoch nicht verwendet werden. Die Angaben sollten immer über das Robots-Tag realisiert werden. Widersprechen sich die Angaben, wird in der Regel eine URL nicht indexiert.

Mehr dazu unter: https://www.deepcrawl.com/blog/best-practice/robots-txt-noindex-the-best-kept-secret-in-seo/

Indexsteuerung über Link-Maskierung

Die Idee der Link-Maskierung besteht darin, einen Link auf einer Seite nicht als Link auszuzeichnen. Dadurch kann der Linkfluss, meist innerhalb einer Seite, dahingehend optimiert werden, dass nur gezielt verlinkte URLs Linkpower erhalten und viele für das Ranking nicht benötigte URLs Suchmaschinen gar nicht erst zur Indexierung angeboten werden. Es wird verhindert, dass die Crawler einen Link überhaupt als solchen erkennen. Wird eine Verlinkung nicht als Link erkannt, sieht der Bot keine Abzweigung, der er folgen möchte.

Durch die Linkmaskierung ist es möglich, die vorhandene Linkpower auf einer Seite gezielter auf ausgewählte Bereiche zu verteilen. Die Nutzer einer Seite bekommen von dieser Maskierung nichts mit und können jede Seite wie gewohnt nutzen.

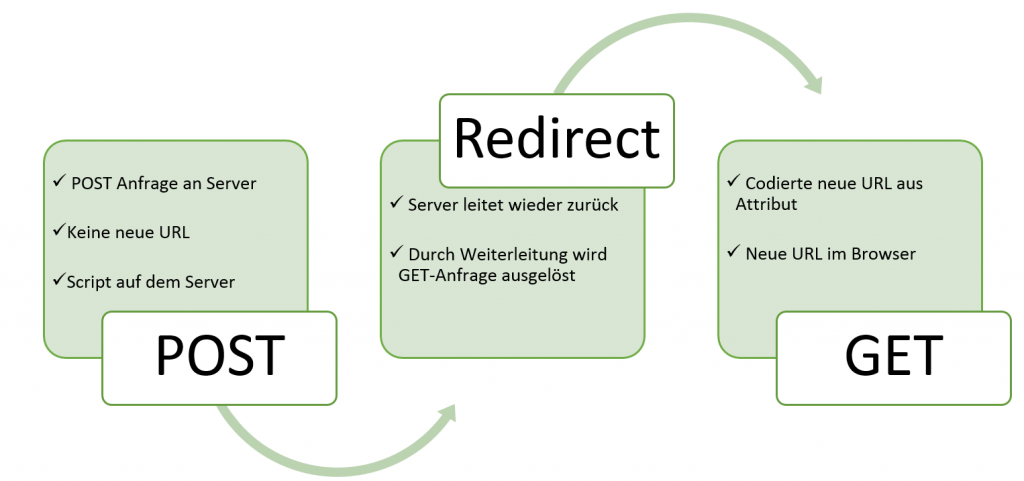

Um Links gezielt zu maskieren, sollten die Links mittels PRG-Pattern-Methode maskiert werden. Google folgt üblicherweise Post-Formularen nicht, daher ist die Methode aktuell effizient, um zusätzlich das Crawl-Budget einer Webseite zu optimieren. URLs, die nur über maskierte Links erreichbar sind, sollen dennoch zusätzlich mit dem <noindex>-Metatag ausgezeichnet werden, um der Aufnahme in den Index, etwa durch externe Verlinkungen, entgegen zu wirken.

Folgende Grafik soll das prinzipielle Procedere einer Linkmaskierung verdeutlichen.

Möglichkeiten der Maskierung über Javascript sind nicht zielführend. Diese werden inzwischen häufig von Google als Links erkannt und erzeugen ein hohen Crawling Aufwand von Google und andere Suchmaschinen. Auch eine Verschlüsselung von Links mittels Base64-Methode wird inzwischen von Suchmaschinen erkannt.

Indexsteuerung über die Google Search Console

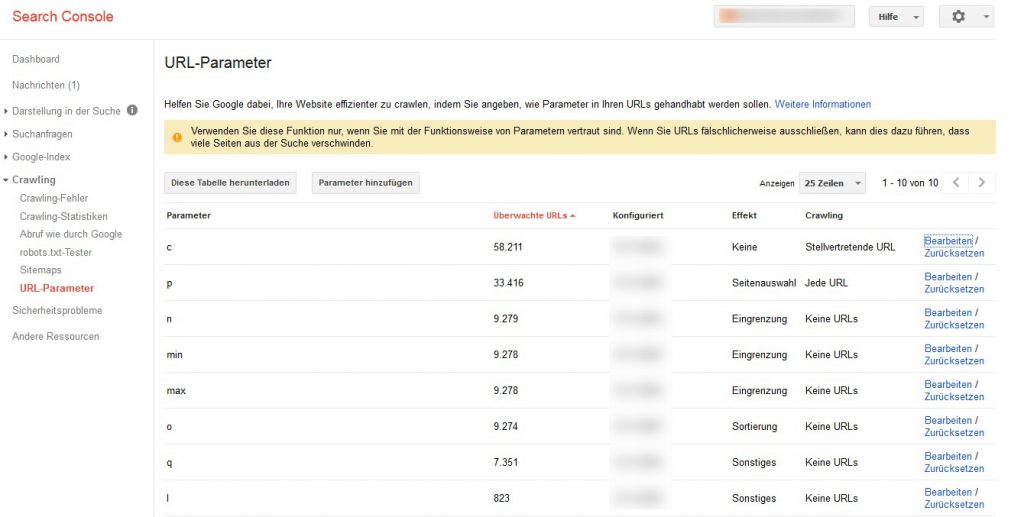

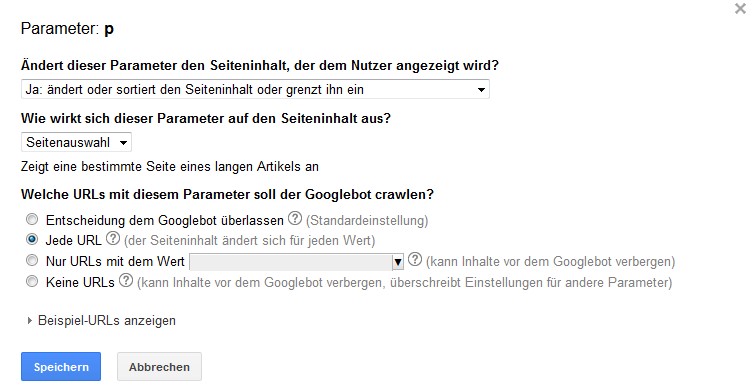

Deklarieren von URL-Parametern

In Shops wird regelmäßig eine URL-Erstellung mittels Parametern realisiert. Sind unterschiedliche Sortierungen oder Filter nur über verschiedene Parameter abgebildet, beispielsweise https://www.otto.de/herrenmode/kategorien/hemden/business-hemden/?farbe=weiss&kragenweite=43 können Suchmaschinen bereits anhand des Aufbaus die Bedeutung der Parameter interpretieren und die Indexierung der URLs bereits selbstständig steuern.

Google bietet in seiner Search-Console Einstellungsmöglichkeiten, wie der Googlebot mit gefundenen Parametern umgehen soll. Für jeden Parameter können mehrere Variablen angegeben werden, in welchem Maß der jeweilige Parameter sich auf die Suchergebnisseite auswirkt. So kann Google eine Entscheidungshilfe gegeben werden, wie und ob Seiten gecrawlt oder auch indexiert werden sollen.

Die Möglichkeit der Steuerung über die Search Console ist sehr einfach gehalten und auch für Laien sehr schnell zu bedienen. Dadurch ist es möglich, Empfehlungen an Google zu geben, ohne in den Code der Webseite eingreifen zu müssen. Allerdings ist damit auch eine große Gefahr verbunden: Mit wenigen Klicks können große Bereiche von Webseiten vom Crawling und damit auch von Aktualisierungen ausgeschlossen werden. Von außen ist es dann nicht ohne weiteres ersichtlich, warum bestimmte Bereiche unter Umständen eine schwächere Performance aufzeigen.

Die Einstellungen der Google Search Console können von anderen Suchmaschinen und Crawler nicht eingesehen werden. Außerdem sind die Angaben für Google auch keine konkreten Anweisungen, an die es sich halten muss. Google selbst schreibt dazu, dass die Einstellungen lediglich dazu führen können, dass die URL nicht gecrawlt wird.

https://support.google.com/webmasters/answer/6080550?hl=de

„Die von Ihnen festgelegten Einstellungen können Google dazu veranlassen, die bevorzugte Version Ihrer URL zu crawlen, oder Google ganz einfach daran hindern, duplizierte Inhalte auf Ihrer Website zu crawlen. „

Die Verwendung der Search Console sollte daher immer verwendet werden, um möglichst viele Informationen vorab zu liefern und die Entscheidung nicht grundsätzlich dem Googlebot zu überlassen. Dieser hat vorrangig die Tendenz möglichst alle Seiten zu erreichen und zu indexieren. Für eine gezielte Steuerung der Indexierung ist eine Auszeichnung auf allen Seiten selbst allerdings unerlässlich.

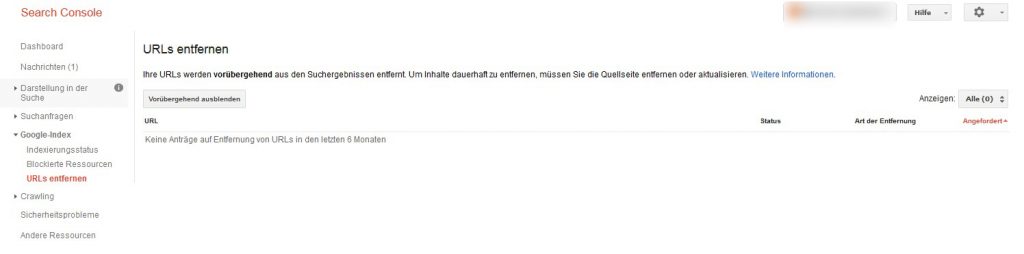

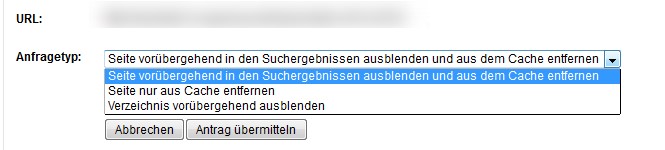

URLs entfernen über die Google Search Console

Die Google Search Console bietet die Möglichkeit, einzelne URLs aus den Suchergebnissen zu entfernen. Dadurch werden Inhalte nur vorübergehend entfernt.

Eine Indexsteuerung über die Funktion im Bereich „Google Index“ ist also nur für kurzfristige und akute Bereinigungen zielführend.

Sinnvoll kann die Verwendung der Funktion sein, wenn beispielsweise eine alte Version bei Google unerwünschterweise noch gecacht ist, oder Seiten endgültig aus dem Index entfernt werden sollen.

Welche Methode soll für eine gezielte Indexierung von URLs verwendet werden?

Google selbst schlägt als mögliche Option, vor unnötige Links mittels des Attributes rel=“nofollow“ auszuzeichnen und so oftmals die entstehende exponentielle Möglichkeit von URLs auf einer Seite einzudämmen. Das reine Crawlen der folgenden URL unterbindet die Methode allerdings nicht. Ein Unterbinden des Crawlings unnötiger Seiten kann nur über die Robots.txt erfolgen. (https://webmasters.googleblog.com/2014/02/faceted-navigation-best-and-5-of-worst.html) Google selbst äußert sich zur Maskierung von Links offiziell an keiner Stelle.

Die Maskierung von Links zu unnötigen URLs ist aktuell (Dezember 2016) die einzige probate Möglichkeit, Seiten gezielt nicht von Suchmaschinen crawlen zu lassen und so die vorhandene Linkpower einer Seite gezielt auf gewünschte Seiten zu steuern.

Idealerweise wird eine Kombination aus der Linkmaskierung und dem Noindex-Tag verwendet. Grundsätzlich gilt:

- Jede Seite die nicht im Index erscheinen soll, muss mit dem Robots-Tag <noindex> ausgezeichnet sein

- Idealerweise befinden sich nur relevante Seiten im Index.

- Links zu „Noindex-Seiten“ können in der Regel maskiert werden. ACHTUNG: Links zu Übersichtsseiten, beispielsweise Archive, Paginierungen oder Liste dürfen NICHT maskiert werden. Ansonsten bricht der Linkfluss ab und die dort verlinkten Produkte oder Seiten sind nicht oder sehr schlecht erreichbar.

Tipp: Um eine Seite kurzfristig von Google indexieren zu lassen, kann man unter folgendem Link Seiten direkt an Google senden, die nicht zum eigenen Domain-Portfolio gehören.

https://www.google.de/intl/de/submit_content.html

Sollen (sehr) viele Domains auf einmal an den Index gesendet werden, kann auch eine Art Sitemap eingebracht werden, auf der alle gewünschten URLs verlinkt sind. Google folgt dann allen Links und indexiert diese gegebenenfalls umgehend.

Lisa Sager leitet seit 2017 das SEO Team der Digital-Marketing-Agentur xpose360 GmbH. Ihre Affinität für das Online Marketing entdeckte sie bereits im Jahr 2011 während Ihres iBWL Studiums an der Universität Augsbur. Sie war zunächst als Werkstudentin, später als Consultant agenturseitig im SEO Bereich tätig.